Kompleksowy monitoring infrastruktury IT

Katgoria: IT Solutions / Utworzono: 02 wrzesień 2011

Kompleksowy monitoring infrastruktury IT

Narzędzia ITSM ManageEngine firmy ZOHO Corp

Niniejszy artykuł chciałbym poświęcić na omówienie zagadnień związanych z monitoringiem infrastruktury informatycznej w sposób kompleksowy, o maksymalnym zakresie, w odniesieniu do usług świadczonych przez dział IT dla biznesu. Czyli monitoring w aspekcie biznesowym – zorientowanie na usługi.

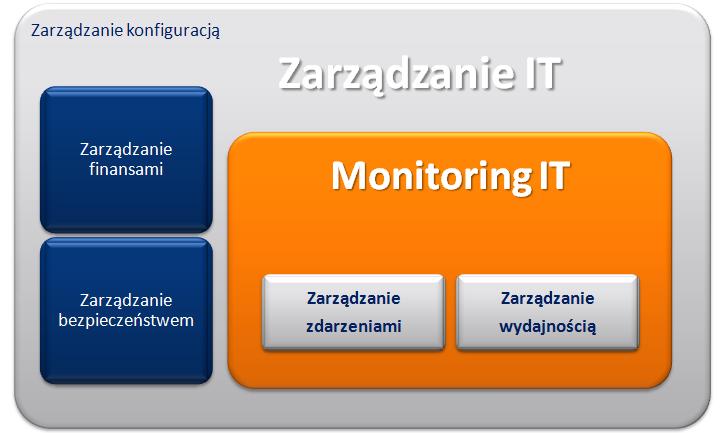

Spróbujmy zastanowić się przez chwilę nad zagadnieniem zarządzania infrastrukturą informatyczną jakim jest monitoring. Czym właściwie jest monitoring, a czym zarządzanie. Monitoring umożliwia przede wszystkim mierzenie, pozyskiwanie informacji, analizę, wyciąganie wniosków w oparciu o gromadzone dane. Zarządzanie ma szerszy aspekt. Posiadając mechanizmy zarządzania możemy planować, rozwijać, projektować…

Monitoring jest podstawowym elementem zarządzania infrastrukturą informatyczną. Dzięki narzędziom monitorującym, możemy zarządzać zdarzeniami w ramach naszych zasobów oraz zarządzać wydajnością. To z kolei umożliwia nam dostęp do funkcji definiowania i szacowania mierników oceniających infrastrukturę. Na tej podstawie możemy rozwijać nasze zasoby, oraz usługi – ale to już jest temat dla zarządzania IT.

Przyjrzyjmy się przez chwilę bibliotekom ITIL® (metodologia zarządzania infrastrukturą informatyczną). To w zasadzie najpopularniejszy, najbardziej elastyczny i kompleksowy zestaw dobrych praktyk w IT, stosowany z sukcesami również w Polsce.

Monitoring jest kluczowym komponentem cyklu życia ITIL®. Bez niego nie ma możliwości oceny wydajności organizacji IT. Definicja monitoringu wg ITIL® mówi o „działaniach związanych z obserwacją sytuacji w celu wykrycia zmian w czasie”. Takie podejście wymusza stałą obserwację, przechwytywanie danych o wydajności i incydentach, jak również dostarczanie analiz na potrzeby procesów decyzyjnych.

Zgodnie z ITIL® monitoring jest wpisany w kilka procesów związanych z cyklem życia usługi: zarządzanie incydentami, zarządzanie problemami, zarządzanie zmianą, zarządzanie pojemnością, a w zasadzie elementy monitoringu bądź informacje jakie dostarcza są wykorzystywane we wszystkich procesach z Continual Service Improvement włącznie.

Jak realizować te postulaty ITSM. W ramach zakresu powinniśmy stosować narzędzia automatyzujące proces monitoringu i rejestracji zdarzeń (czyli nie ping od czasu do czasu uruchamiany ręcznie przez administratora na wybiórcze maszyny), ale również automatyzujące działania w ramach monitoringu, czyli analitykę i powiadamianie. Powinniśmy również starać się ograniczać ilość powiadomień generowanych przez urządzenia ze sobą powiązane (router – switch – serwer), nawet jeżeli nie znajdują się w jednej warstwie. Przede wszystkim powinniśmy jednak możliwie maksymalnie i w sposób uzasadniony ekonomicznie i biznesowo rozszerzyć obszar monitorowania infrastruktury.

Przyjrzyjmy się przez chwilę bibliotekom ITIL® (metodologia zarządzania infrastrukturą informatyczną). To w zasadzie najpopularniejszy, najbardziej elastyczny i kompleksowy zestaw dobrych praktyk w IT, stosowany z sukcesami również w Polsce.

Monitoring jest kluczowym komponentem cyklu życia ITIL®. Bez niego nie ma możliwości oceny wydajności organizacji IT. Definicja monitoringu wg ITIL® mówi o „działaniach związanych z obserwacją sytuacji w celu wykrycia zmian w czasie”. Takie podejście wymusza stałą obserwację, przechwytywanie danych o wydajności i incydentach, jak również dostarczanie analiz na potrzeby procesów decyzyjnych.

Zgodnie z ITIL® monitoring jest wpisany w kilka procesów związanych z cyklem życia usługi: zarządzanie incydentami, zarządzanie problemami, zarządzanie zmianą, zarządzanie pojemnością, a w zasadzie elementy monitoringu bądź informacje jakie dostarcza są wykorzystywane we wszystkich procesach z Continual Service Improvement włącznie.

Jak realizować te postulaty ITSM. W ramach zakresu powinniśmy stosować narzędzia automatyzujące proces monitoringu i rejestracji zdarzeń (czyli nie ping od czasu do czasu uruchamiany ręcznie przez administratora na wybiórcze maszyny), ale również automatyzujące działania w ramach monitoringu, czyli analitykę i powiadamianie. Powinniśmy również starać się ograniczać ilość powiadomień generowanych przez urządzenia ze sobą powiązane (router – switch – serwer), nawet jeżeli nie znajdują się w jednej warstwie. Przede wszystkim powinniśmy jednak możliwie maksymalnie i w sposób uzasadniony ekonomicznie i biznesowo rozszerzyć obszar monitorowania infrastruktury.

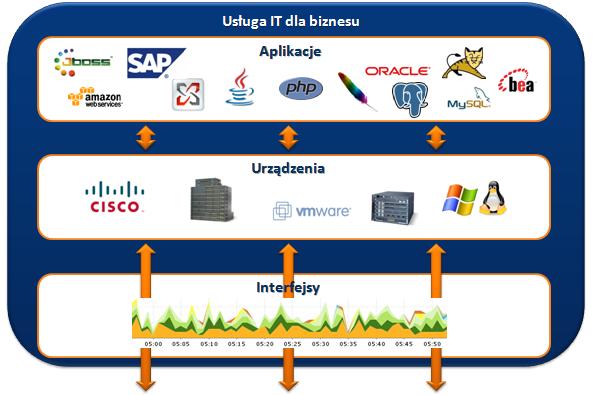

Kiedy spojrzymy na naszą infrastrukturę IT w aspekcie świadczonych przez departament IT usług dla biznesu, zauważymy, że proces świadczenia tej usługi opiera się na takich trzech kluczowych obszarach/warstwach. Warstwa najbliższa użytkownikowi, czyli aplikacje (ERP, CRM, BI, usługi mailowe). Aplikacje te pracują na serwerach/stacjach roboczych, połączonych ze sobą i tworzących sieć w oparciu o strukturę switchy i routerów (ogólnie urządzeń dostępowych). Sam proces komunikacji przebiega w oparciu o ruch na poszczególnych interfejsach. Monitoring tych trzech warstw jest kluczowy z punktu widzenia dostępności świadczonych usług IT dla biznesu.

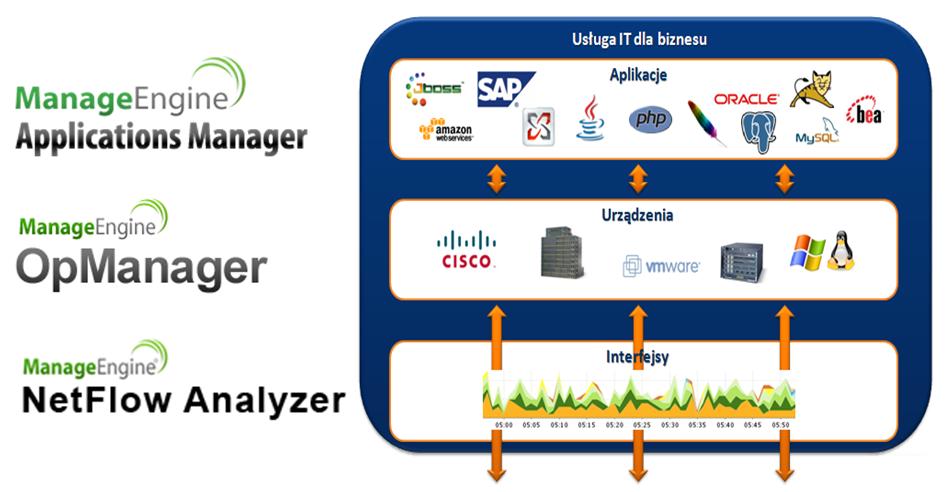

Produkty ManageEngine (www.manageengine.pl) firmy ZOHO Corp, której wyłącznym dystrybutorem na Polskę jest firma MWT Solutions Sp. z o.o. (www.mwtsolutions.pl), dostarczają nam właśnie zestaw narzędzi, optymalizujący zakres monitorowania naszej infrastruktury informatycznej. Produkty Applications Manager (http://mwtsolutions.pl/content/view/87/39/lang,pl/), OpManager (http://mwtsolutions.pl/content/view/6/31/lang,pl/) i NetFlow Analyzer (http://mwtsolutions.pl/content/view/539/322/lang,pl/), tworzą wspólnie zintegrowane, wygodne w pracy i intuicyjne środowisko monitoringu IT.

Produkty ManageEngine (www.manageengine.pl) firmy ZOHO Corp, której wyłącznym dystrybutorem na Polskę jest firma MWT Solutions Sp. z o.o. (www.mwtsolutions.pl), dostarczają nam właśnie zestaw narzędzi, optymalizujący zakres monitorowania naszej infrastruktury informatycznej. Produkty Applications Manager (http://mwtsolutions.pl/content/view/87/39/lang,pl/), OpManager (http://mwtsolutions.pl/content/view/6/31/lang,pl/) i NetFlow Analyzer (http://mwtsolutions.pl/content/view/539/322/lang,pl/), tworzą wspólnie zintegrowane, wygodne w pracy i intuicyjne środowisko monitoringu IT.

Systemy te doskonale wpasowują się w trzywarstwowy model usług IT w biznesie. Applications Manager odpowiada za monitorowanie końcówek usług – aplikacji i komponentów IT biorących udział w realizacji usługi. OpManager stale bada dostępność i wydajność urządzeń sieciowych, takich jak switche, routery, serwery. Z kolei NetFlow Analyzer monitoruje przepustowość łączy i analizuje zużycie pasma pod kątem krytycznych aplikacji biznesowych.

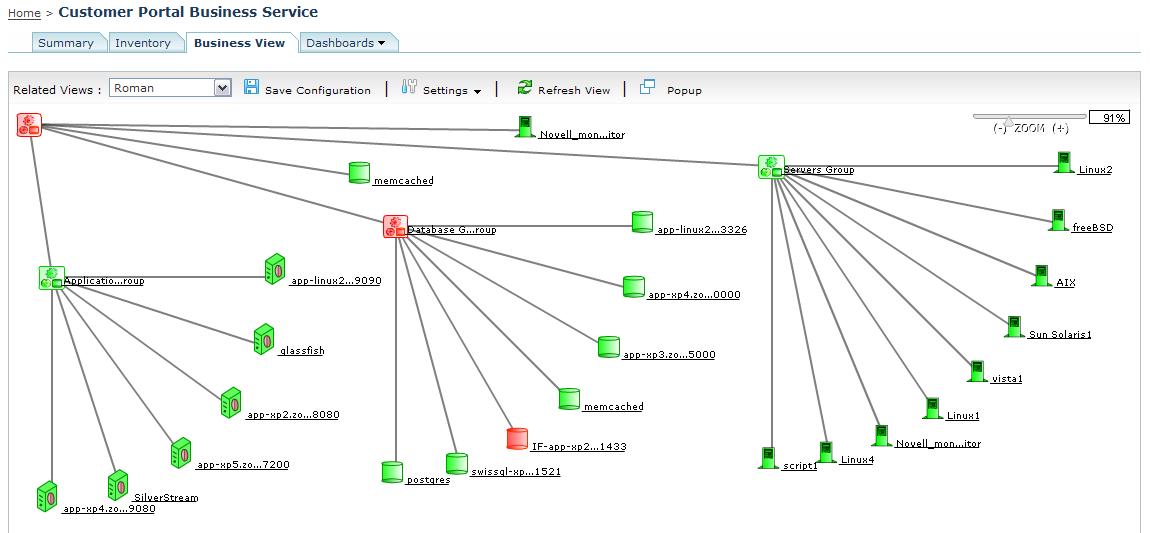

Applications Manager zapewnia administratorom ujednolicony, całościowy wgląd w infrastrukturę IT organizacji. Co możemy monitorować? Przede wszystkim aplikacje biznesowe, wykorzystywane w ramach dostarczania usług IT: systemy ERP, serwery bazodanowe, serwery aplikacji, portale internetowe, usługi typu SaaS (Software as a Service). Na podstawie danych zebranych w ten sposób, możemy również dokonywać badań anomalii.

Applications Manager zapewnia administratorom ujednolicony, całościowy wgląd w infrastrukturę IT organizacji. Co możemy monitorować? Przede wszystkim aplikacje biznesowe, wykorzystywane w ramach dostarczania usług IT: systemy ERP, serwery bazodanowe, serwery aplikacji, portale internetowe, usługi typu SaaS (Software as a Service). Na podstawie danych zebranych w ten sposób, możemy również dokonywać badań anomalii.

Jakie informacje otrzymujemy? Przede wszystkim dane dotyczące dostępności, oraz zdrowia nie tylko poszczególnych komponentów IT, ale przede wszystkim całych usług, dostarczenie których zależy od tych komponentów.

Dzięki systemowi OpManager dostajemy wgląd w prace naszej sieci z perspektywy administratora sieciowego. Możemy monitorować różne parametry serwerów, stacji roboczych, usług postawionych na urządzeniach, baz danych. Otrzymujemy profesjonalne narzędzie monitoringu z rozbudowanym systemem generowania alertów oraz powiadomień. Dzięki temu nasze podejście do zagrożeń staje się bardziej pro aktywne. Poprzez integrację komponenty sieciowe wykryte przez OpManager są widoczne również w Applications Manager.

Dzięki systemowi OpManager dostajemy wgląd w prace naszej sieci z perspektywy administratora sieciowego. Możemy monitorować różne parametry serwerów, stacji roboczych, usług postawionych na urządzeniach, baz danych. Otrzymujemy profesjonalne narzędzie monitoringu z rozbudowanym systemem generowania alertów oraz powiadomień. Dzięki temu nasze podejście do zagrożeń staje się bardziej pro aktywne. Poprzez integrację komponenty sieciowe wykryte przez OpManager są widoczne również w Applications Manager.

Co daje nam OpManager? Monitorowanie obciążenia procesora, monitorowanie pamięci operacyjnej oraz wykorzystania miejsca na dyskach, analizę i identyfikację urządzeń o wysokim obciążeniu procesora, pamięci lub dysków, egzotyczne funkcje, jak monitorowanie statusu urządzeń typu UPS (aspekty zarządzania dostępnością na niskiej warstwie), monitorowanie czasu zasilania awaryjnego oraz stanu akumulatorów, powiadomienia o zacięciu papieru lub jego braku w drukarkach, monitorowanie poziomu tuszy i tonerów. W zasadzie możemy uzyskać dowolną informację występującą w obiektach MIB.

Z kolei NetFlow Analyzer jest rozwiązaniem wykorzystywanym w celu optymalizacji działania sieci tak, aby zapewnić jej najwyższą wydajność. Jest to narzędzie, które umożliwia dokładny wgląd w to, co dzieje się w sieci – aplikacja pozwala nam uzyskać wiedzę w czasie rzeczywistym na temat tego jak ruch w sieci wpływa na funkcjonowanie aplikacji biznesowych. System opiera się na protokole NetFlow i gromadzi dane z routerów i przełączników, a następnie prezentuje te dane w postaci analizy ruchu sieci oraz monitoruje ilość danych przesłanych i odebranych w danym czasie.

Z kolei NetFlow Analyzer jest rozwiązaniem wykorzystywanym w celu optymalizacji działania sieci tak, aby zapewnić jej najwyższą wydajność. Jest to narzędzie, które umożliwia dokładny wgląd w to, co dzieje się w sieci – aplikacja pozwala nam uzyskać wiedzę w czasie rzeczywistym na temat tego jak ruch w sieci wpływa na funkcjonowanie aplikacji biznesowych. System opiera się na protokole NetFlow i gromadzi dane z routerów i przełączników, a następnie prezentuje te dane w postaci analizy ruchu sieci oraz monitoruje ilość danych przesłanych i odebranych w danym czasie.

Co daje nam NetFlow? Przede wszystkim informacje o zużyciu łącza przez określone aplikacje. Udział w ruchu sieciowym z rozbiciem na poszczególne aplikacje, pozwala uzyskać natychmiastowy wgląd w dane na temat aplikacji generujących największy ruch. Dane takie można prześledzić w celu zlokalizowania głównych źródeł oraz kierunków przepływu danych dla poszczególnych aplikacji. Dzięki takim szczegółowym danym, lokalizowanie i rozwiązywanie problemów, np. ograniczonej dostępności usług biznesowych (np. voip), zajmuje znacznie mniej czasu niż ma to miejsce przy użyciu tradycyjnych narzędzi.

Te trzy narzędzia doskonale się uzupełniają i integrują ze sobą. Właśnie możliwość integracji znacznie rozbudowuje funkcjonalność kompleksowego monitorowania usług. Jeżeli założymy, że grupa w systemie Applications Manager reprezentuje komponenty niezbędne do dostarczenia usługi, to przed integracją mieliśmy możliwość monitorowania aplikacji i systemów. Po integracji z systemem OpManager dochodzi nam możliwość dokładniejszego monitoringu fizycznych serwerów oraz routerów czy switchy, które mogą być również uwzględniane w logice generowania alarmów. Zatem wraz z monitoringiem zaczynamy schodzić o warstwę niżej. Jeżeli dodatkowo zintegrujemy system OpManager z systemem NetFlow Analyzer, to uzupełnimy monitoring usług o wysycenie pasma pod kątem krytycznych aplikacji biznesowych. Oprócz podstawowych statystyk dla interfejsu, uzyskamy wgląd w dane dotyczące przepływu z podziałem na poszczególne protokoły/aplikacje ustawione w NetFlow Analyzer. Możemy je dalej analizować wybierając dowolny atrybut. Zostaniemy przeniesieni już do samej aplikacji NetFlow Analyzer, która daje nam możliwości dogłębnej analizy potoku danych. W ten sposób, integrując Applications Manager z OpManager i dalej OpManager z NetFlow Analyzer uzyskaliśmy kompleksowy przegląd całej naszej infrastruktury pod kątem usług IT.

Trzeba pamiętać, że nie ma jednej skutecznej metodyki pracy na zintegrowanych systemach. Warto jednak wychodzić od Applications Manager, zwłaszcza gdy zależy nam na monitorowaniu dostępności usług. Wtedy, najlepszym rozwiązaniem jest wsparcie systemu informacjami dostarczanymi przez OpManager oraz NetFlow Analyzer. Taktyka oraz sposoby monitorowania zależą oczywiście od administratorów oraz osób odpowiedzialnych za usługę, jednak każdy powinien zastanowić się nad rozwiązaniem zwiększającym możliwości oraz wydajność pracy urządzeń, które odgrywają nadrzędną rolę we współczesnym biznesie.

Applications Manager zapewnia administratorom ujednolicony, całościowy wgląd w infrastrukturę IT organizacji. Co możemy monitorować? Przede wszystkim aplikacje biznesowe, wykorzystywane w ramach dostarczania usług IT: systemy ERP, serwery bazodanowe, serwery aplikacji, portale internetowe, usługi typu SaaS (Software as a Service). Na podstawie danych zebranych w ten sposób, możemy również dokonywać badań anomalii.

Applications Manager zapewnia administratorom ujednolicony, całościowy wgląd w infrastrukturę IT organizacji. Co możemy monitorować? Przede wszystkim aplikacje biznesowe, wykorzystywane w ramach dostarczania usług IT: systemy ERP, serwery bazodanowe, serwery aplikacji, portale internetowe, usługi typu SaaS (Software as a Service). Na podstawie danych zebranych w ten sposób, możemy również dokonywać badań anomalii. Dzięki systemowi OpManager dostajemy wgląd w prace naszej sieci z perspektywy administratora sieciowego. Możemy monitorować różne parametry serwerów, stacji roboczych, usług postawionych na urządzeniach, baz danych. Otrzymujemy profesjonalne narzędzie monitoringu z rozbudowanym systemem generowania alertów oraz powiadomień. Dzięki temu nasze podejście do zagrożeń staje się bardziej pro aktywne. Poprzez integrację komponenty sieciowe wykryte przez OpManager są widoczne również w Applications Manager.

Dzięki systemowi OpManager dostajemy wgląd w prace naszej sieci z perspektywy administratora sieciowego. Możemy monitorować różne parametry serwerów, stacji roboczych, usług postawionych na urządzeniach, baz danych. Otrzymujemy profesjonalne narzędzie monitoringu z rozbudowanym systemem generowania alertów oraz powiadomień. Dzięki temu nasze podejście do zagrożeń staje się bardziej pro aktywne. Poprzez integrację komponenty sieciowe wykryte przez OpManager są widoczne również w Applications Manager. Z kolei NetFlow Analyzer jest rozwiązaniem wykorzystywanym w celu optymalizacji działania sieci tak, aby zapewnić jej najwyższą wydajność. Jest to narzędzie, które umożliwia dokładny wgląd w to, co dzieje się w sieci – aplikacja pozwala nam uzyskać wiedzę w czasie rzeczywistym na temat tego jak ruch w sieci wpływa na funkcjonowanie aplikacji biznesowych. System opiera się na protokole NetFlow i gromadzi dane z routerów i przełączników, a następnie prezentuje te dane w postaci analizy ruchu sieci oraz monitoruje ilość danych przesłanych i odebranych w danym czasie.

Z kolei NetFlow Analyzer jest rozwiązaniem wykorzystywanym w celu optymalizacji działania sieci tak, aby zapewnić jej najwyższą wydajność. Jest to narzędzie, które umożliwia dokładny wgląd w to, co dzieje się w sieci – aplikacja pozwala nam uzyskać wiedzę w czasie rzeczywistym na temat tego jak ruch w sieci wpływa na funkcjonowanie aplikacji biznesowych. System opiera się na protokole NetFlow i gromadzi dane z routerów i przełączników, a następnie prezentuje te dane w postaci analizy ruchu sieci oraz monitoruje ilość danych przesłanych i odebranych w danym czasie.

Łukasz Harasimowicz, Product Manager, MWT Solutions Sp. z o.o. Absolwent wydziału Informatyki i Gospodarki Elektronicznej na Uniwersytecie Ekonomicznym w Poznaniu. Od ponad 5 lat związany z branżą IT, a w szczególności z systemami zarządzania infrastrukturą teleinformatyczną.

Łukasz Harasimowicz, Product Manager, MWT Solutions Sp. z o.o. Absolwent wydziału Informatyki i Gospodarki Elektronicznej na Uniwersytecie Ekonomicznym w Poznaniu. Od ponad 5 lat związany z branżą IT, a w szczególności z systemami zarządzania infrastrukturą teleinformatyczną.

Najnowsze wiadomości

Customer-specific AI: dlaczego w 2026 roku to ona przesądza o realnym wpływie AI na biznes

W 2026 roku sztuczna inteligencja przestaje być ciekawostką technologiczną, a zaczyna być rozliczana z realnego wpływu na biznes. Organizacje oczekują dziś decyzji, którym można zaufać, procesów działających przewidywalnie oraz doświadczeń klientów, które są spójne w skali. W tym kontekście coraz większe znaczenie zyskuje customer-specific AI - podejście, w którym inteligencja jest osadzona w danych, procesach i regułach konkretnej firmy, a nie oparta na generycznych, uśrednionych modelach.

PROMAG S.A. rozpoczyna wdrożenie systemu ERP IFS Cloud we współpracy z L-Systems

PROMAG S.A., lider w obszarze intralogistyki, rozpoczął wdrożenie systemu ERP IFS Cloud, który ma wesprzeć dalszy rozwój firmy oraz integrację kluczowych procesów biznesowych. Projekt realizowany jest we współpracy z firmą L-Systems i obejmuje m.in. obszary finansów, produkcji, logistyki, projektów oraz serwisu, odpowiadając na rosnącą skalę i złożoność realizowanych przedsięwzięć.

SkyAlyne stawia na IFS dla utrzymania floty RCAF

SkyAlyne, główny wykonawca programu Future Aircrew Training (FAcT), wybrał IFS Cloud for Aviation Maintenance jako cyfrową platformę do obsługi technicznej lotnictwa i zarządzania majątkiem. Wdrożenie ma zapewnić wgląd w czasie rzeczywistym w utrzymanie floty, zasoby i zgodność, ograniczyć przestoje oraz zwiększyć dostępność samolotów szkoleniowych RCAF w skali całego kraju. To ważny krok w modernizacji kanadyjskiego systemu szkolenia załóg lotniczych.

Wykorzystanie AI w firmach rośnie, ale wolniej, niż oczekiwano. Towarzyszy temu sporo rozczarowań

Wykorzystanie sztucznej inteligencji w firmach rośnie, ale tempo realnych wdrożeń pozostaje znacznie wolniejsze od wcześniejszych oczekiwań rynku. Dane pokazują, że z rozwiązań AI korzysta dziś wciąż niewiele przedsiębiorstw, a menedżerowie coraz częściej wskazują na bariery regulacyjne, koszty oraz brak powtarzalnych efektów biznesowych. W praktyce technologia jest testowana głównie w wybranych obszarach, a kluczowe decyzje nadal pozostają po stronie człowieka. Również w firmach, które wdrożyły AI, nierzadko towarzyszą temu rozczarowania.

Europejski przemysł cyfryzuje się zbyt wolno – ERP, chmura i AI stają się koniecznością

Europejski przemysł średniej wielkości wie, że cyfryzacja jest koniecznością, ale wciąż nie nadąża za tempem zmian. Ponad 60% firm ocenia swoje postępy w transformacji cyfrowej jako zbyt wolne, mimo rosnącej presji konkurencyjnej, regulacyjnej i kosztowej. Raport Forterro pokazuje wyraźną lukę między świadomością potrzeby inwestycji w chmurę, ERP i AI a realną zdolnością do ich wdrożenia – ograniczaną przez braki kompetencyjne, budżety i gotowość organizacyjną.

Europejski przemysł średniej wielkości wie, że cyfryzacja jest koniecznością, ale wciąż nie nadąża za tempem zmian. Ponad 60% firm ocenia swoje postępy w transformacji cyfrowej jako zbyt wolne, mimo rosnącej presji konkurencyjnej, regulacyjnej i kosztowej. Raport Forterro pokazuje wyraźną lukę między świadomością potrzeby inwestycji w chmurę, ERP i AI a realną zdolnością do ich wdrożenia – ograniczaną przez braki kompetencyjne, budżety i gotowość organizacyjną.

Najnowsze artykuły

5 pułapek zarządzania zmianą, które mogą wykoleić transformację cyfrową i wdrożenie ERP

Dlaczego jedne wdrożenia ERP dowożą korzyści, a inne kończą się frustracją, obejściami w Excelu i spadkiem zaufania do systemu? Najczęściej decyduje nie technologia, lecz to, jak organizacja prowadzi zmianę: czy liderzy biorą odpowiedzialność za decyzje czy tempo jest dopasowane do zdolności absorpcji oraz czy ludzie dostają klarowność ról i realne kompetencje. Do tego dochodzi pytanie: co po go-live - stabilizacja czy chaos w firmie? Poniżej znajdziesz 5 pułapek, które najczęściej wykolejają transformację i praktyczne sposoby, jak im zapobiec.

SAP vs Oracle vs Microsoft: jak naprawdę wygląda chmura i sztuczna inteligencja w ERP

Wybór systemu ERP w erze chmury i sztucznej inteligencji to decyzja, która determinuje sposób działania organizacji na lata — a często także jej zdolność do skalowania, adaptacji i realnej transformacji cyfrowej. SAP, Oracle i Microsoft oferują dziś rozwiązania, które na pierwszy rzut oka wyglądają podobnie, lecz w praktyce reprezentują zupełnie odmienne podejścia do chmury, AI i zarządzania zmianą. Ten artykuł pokazuje, gdzie kończą się deklaracje, a zaczynają realne konsekwencje biznesowe wyboru ERP.

Transformacja cyfrowa z perspektywy CFO: 5 rzeczy, które przesądzają o sukcesie (albo o kosztownej porażce)

Transformacja cyfrowa w finansach często zaczyna się od pytania o ERP, ale w praktyce rzadko sprowadza się wyłącznie do wyboru systemu. Dla CFO kluczowe jest nie tylko „czy robimy pełną wymianę ERP”, lecz także jak policzyć ryzyko operacyjne po uruchomieniu, ocenić wpływ modelu chmurowego na koszty OPEX oraz utrzymać audytowalność i kontrolę wewnętrzną w nowym modelu działania firmy.

Agentic AI rewolucjonizuje HR i doświadczenia pracowników

Agentic AI zmienia HR: zamiast odpowiadać na pytania, samodzielnie realizuje zadania, koordynuje procesy i podejmuje decyzje zgodnie z polityką firmy. To przełom porównywalny z transformacją CRM – teraz dotyczy doświadczenia pracownika. Zyskują HR managerowie, CIO i CEO: mniej operacji, więcej strategii. W artykule wyjaśniamy, jak ta technologia redefiniuje rolę HR i daje organizacjom przewagę, której nie da się łatwo nadrobić.

Composable ERP: Przewodnik po nowoczesnej architekturze biznesowej

Czy Twój system ERP nadąża za tempem zmian rynkowych, czy stał się cyfrową kotwicą hamującą rozwój? W dobie nieciągłości biznesowej tradycyjne monolity ustępują miejsca elastycznej architekturze Composable ERP. To rewolucyjne podejście pozwala budować środowisko IT z niezależnych modułów (PBC) niczym z klocków, zapewniając zwinność nieosiągalną dla systemów z przeszłości. W tym raporcie odkryjesz, jak uniknąć pułapki długu technologicznego, poznasz strategie liderów rynku (od SAP po MACH Alliance) i wyciągniesz lekcje z kosztownych błędów gigantów takich jak Ulta Beauty. To Twój strategiczny przewodnik po transformacji z cyfrowego "betonu" w adaptacyjną "plastelinę".

Oferty Pracy

-

Młodszy konsultant programista Microsoft Dynamics 365 Business Central

-

Konsultant programista Microsoft Dynamics 365 Business Central

-

Konsultant Microsoft Dynamics 365

-

Konsultant Wdrożeniowy Symfonia – księgowość

-

Microsoft Fabric Engineer (MFE)

-

Data/Business Analyst (PBI/Fabric)

-

CRM consultant

-

Starszy architekt systemów rozproszonych

-

Inżynier Zastosowań AI

Przeczytaj Również

Wykorzystanie AI w firmach rośnie, ale wolniej, niż oczekiwano. Towarzyszy temu sporo rozczarowań

Wykorzystanie sztucznej inteligencji w firmach rośnie, ale tempo realnych wdrożeń pozostaje znaczni… / Czytaj więcej

Vertiv Frontiers: 5 trendów, które przeprojektują centra danych pod „fabryki AI”

Centra danych wchodzą w erę „fabryk AI”, gdzie o przewadze nie decyduje już sama skala, lecz zdolno… / Czytaj więcej

Cyberbezpieczeństwo 2026. 6 trendów, które wymuszą nowe podejście do AI, danych i tożsamości

Rok 2026 zapowiada się jako moment przełomu w świecie cyfrowego bezpieczeństwa. W obliczu dynamiczn… / Czytaj więcej

Jurysdykcja danych w chmurze: dlaczego polskie firmy coraz częściej wybierają „gdzie leżą” ich system

Jurysdykcja danych przestała być detalem w umowach chmurowych – dziś decyduje o zgodności, bezpiecz… / Czytaj więcej

Tylko 7% firm w Europie wykorzystuje w pełni potencjał AI

72% firm w regionie EMEA uznaje rozwój narzędzi bazujących na sztucznej inteligencji za priorytet s… / Czytaj więcej

Chmura publiczna w Unii Europejskiej – między innowacją a odpowiedzialnością za dane

Transformacja cyfrowa w Europie coraz mocniej opiera się na chmurze publicznej, która stała się fun… / Czytaj więcej