Nowoczesne systemy Business IntelligenceI – OLAP kontra „In-Memory”

Katgoria: BUSINESS INTELLIGENCE / Utworzono: 21 marzec 2012

Nowoczesne systemy Business Intelligence – OLAP kontra „In-Memory”

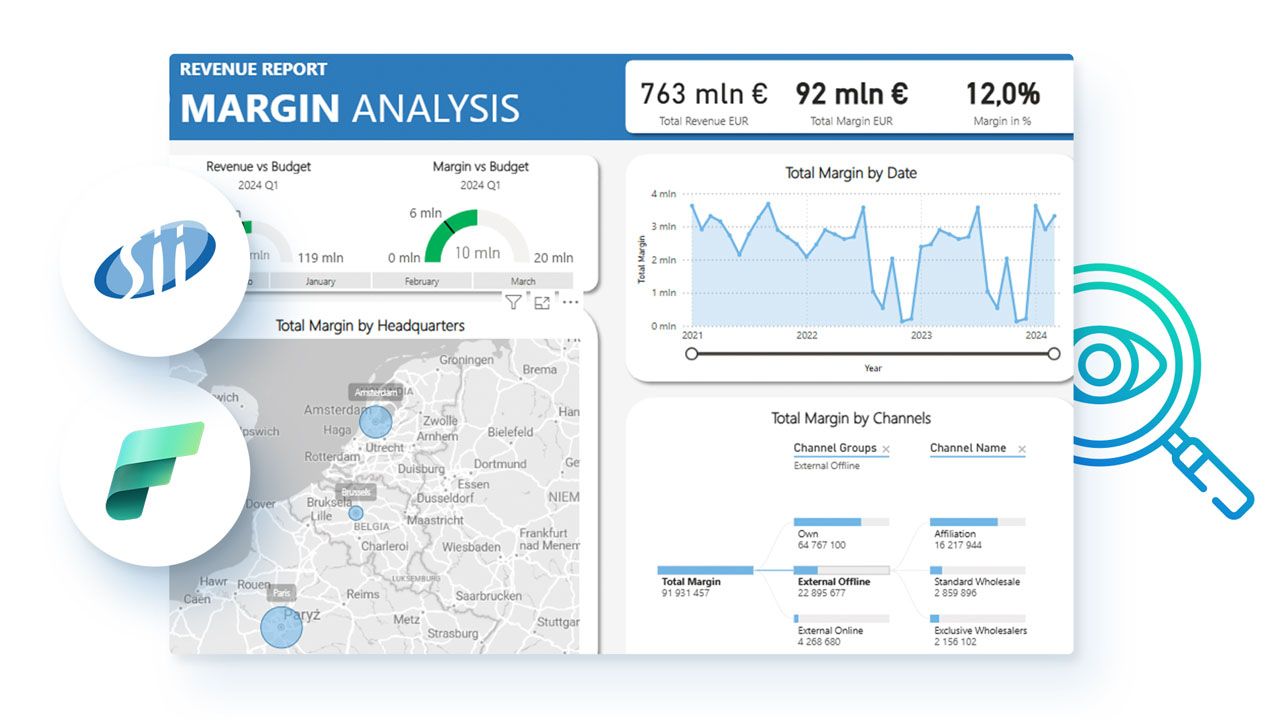

Trudno dziś wyobrazić sobie funkcjonowanie przedsiębiorstwa bez analiz dotyczących trendów sprzedaży, wyników finansowych czy innych kluczowych z punktu widzenia danej firmy wskaźników efektywności jej działania. Jednym z głównych służących do tego celu narzędzi są systemy Business Intelligence.

Trudno dziś wyobrazić sobie funkcjonowanie przedsiębiorstwa bez analiz dotyczących trendów sprzedaży, wyników finansowych czy innych kluczowych z punktu widzenia danej firmy wskaźników efektywności jej działania. Jednym z głównych służących do tego celu narzędzi są systemy Business Intelligence.Obecnie na rynku systemów klasy Business Intelligence (BI) można się spotkać z dwoma podstawowymi ich rodzajami. Pierwszy z nich należy do klasycznych systemów bazujących na technologiach wyszukiwania i przetwarzania danych OLAP (ang. OnLine Analytical Processing), drugi to systemy klasy „In-Memory”. Przyjrzyjmy się zatem, na czym polegają różnice między nimi, dla kogo są one przeznaczone i jakie kryteria należy brać pod uwagę przed zakupem systemu BI należącego do jednej lub drugiej kategorii.

Architektura systemów

Architektura systemów

Zacznijmy może od różnic. Podstawowa różnica między systemami BI „In-Memory” i OLAP leży w samej ich architekturze. Klasyczne rozwiązania techniczne, wykorzystujące technologię OLAP, są oparte o centralnie zarządzane serwery, z zainstalowaną na nich hurtownią danych, w której przechowywane są wszelkie informacje potrzebne do prowadzenia wielowymiarowych analiz zarządczych. Dane te pochodzą z systemów źródłowych, takich jak systemy ERP, CRM lub innych systemów ewidencjonujących określone transakcje.

W tego typu systemach nacisk położony jest na wydajność i moc obliczeniową centralnego miejsca, czyli serwera OLAP, do którego podłączeni są poszczególni użytkownicy. Wszelkie operacje odbywają właśnie na centralnym serwerze, a jego klienci otrzymują dane już przetworzone, np. w formie różnych analiz: raportów, tabel przestawnych itp.

Taka architektura sprawia, że w praktyce nie ma wielkiego znaczenia, jaką mocą obliczeniową dysponują komputery użytkowników końcowych. Ten model systemów Business Intelligence bazujących na technologii OLAP ma ścisły związek z historią rozwoju sprzętu komputerowego. Powstał on w czasach, gdy tylko potężne serwery, np. komputery klasy mainframe, były w stanie poradzić sobie z szybkim przetwarzaniem ogromnych ilości danych i takie operacje były nie do pomyślenia w przypadku komputerów osobistych.

Dziś sytuacja zmieniła się diametralnie. Współczesne pecety niejednokrotnie przewyższają mocą obliczeniową dawne serwery i z powodzeniem są w stanie poradzić sobie z większością zadań, jakie wykonują użytkownicy systemów klasy BI. Ten fakt leży u podstaw powstania nowej generacji systemów Business Intelligence, tzw. systemów „In-Memory”, których architektura pozwala na przetwarzanie danych właśnie w pamięci operacyjnej komputerów osobistych. Czy to oznacza, że można połączyć system BI „In-Memory” z dowolnym systemem transakcyjnym? Teoretycznie tak.

W praktyce bywa nieco inaczej i ma to związek z efektywnością zarządzania zasobami firmy. Aby maksymalizować efektywność gospodarowania zasobami, nie ma zazwyczaj sensu, aby cała zawartość bazy danych źródłowego systemu transakcyjnego (firmowy ERP, CRM czy inny przeznaczony do obsługi konkretnego obszaru funkcjonalnego system) była ładowana do pamięci stacji roboczych wszystkich użytkowników systemu BI. Trafiają tam tylko dane źródłowe z obszarów, które interesują poszczególne osoby: np. sprzedaż, koszty, stany magazynowe, klienci itp.

Opisując w dużym uproszczeniu, menedżer, który chce analizować wybrane obszary działalności firmy, otrzymuje na swój komputer odpowiedni zakres danych i na jego podstawie może prowadzić dowolne analizy, generować raporty, sprawdzać wybrane wskaźniki ekonomiczne itp. Nie potrzebuje do tego celu mocy obliczeniowej serwera, tak jak to miało miejsce w systemach korzystających z architektury opartej na technologii OLAP.

Kryteria wyboru

Niewątpliwie systemy klasy „In-Memory” cieszą się coraz większym zainteresowaniem. Spory wpływ na to mają takie czynniki, jak coraz niższe ceny sprzętu, w tym kluczowej dla tego typu systemów BI pamięci RAM, oraz wydajniejsze (i również coraz tańsze) procesory. Dzięki temu udaje się osiągnąć stosunkowo krótki czas implementacji systemów BI typu „In-Memory” oraz niższe koszty związanych z nimi usług wdrożeniowych. Stając przed wyborem typu systemu Business Intelligence, trzeba jednak bardzo dokładnie rozważyć kilka dodatkowych kwestii.

Oszczędności w budżecie i czasie potrzebnym na wdrożenie to bardzo atrakcyjne korzyści, jednak, podobnie jak w wypadku wdrożeń systemów transakcyjnych, nie tylko one decydują o powodzeniu całego przedsięwzięcia. Bardzo ważne są również przeznaczenie systemu, liczba i lokalizacja użytkowników, organizacja procesów biznesowych czy choćby ilość i jakość danych źródłowych. W przypadku pierwszego elementu, czyli przeznaczenia systemu, chodzi o to, czy potrzebujemy narzędzia tylko do analiz, czy też może do budżetowania, raportowania i zaawansowanych symulacji np. z wykorzystaniem statystyki. Do tego dochodzi kwestia zakresu tych zastosowań, to znaczy, czy analizujemy i prognozujemy tylko wybrany wycinek z działalności naszej firmy, czy też zajmujemy się kompleksowo wszystkimi obszarami aktywności gospodarczej.

Z kolei liczba i lokalizacja użytkowników, zwłaszcza w powiązaniu z ich funkcją w organizacji, firmowym obiegiem informacji i wymaganiami odnośnie aktualności danych determinuje sposób pracy z systemem BI. Chodzi tu o pracę z aplikacją (tzw. gruby klient) w trybie przeglądarkowym, zintegrowanym z systemem BI arkuszem kalkulacyjnym, ewentualnie pracą w trybie off-line, na wybranej porcji danych – tzw. kostce lub kostkach lokalnych, które replikowane są z hurtownią/repozytorium systemu co określony interwał czasu lub na żądanie. Lokalizacja i infrastruktura mają też wpływ na to, czy będzie istniała możliwość przesyłania ze źródła dość znaczącej ilości danych i jak długo będzie to trwało. W tym wypadku duże znaczenie ma chociażby przepustowość dostępnych łączy internetowych.

Organizacja procesów biznesowych to zwykle kwestie związane z funkcjami poszczególnych użytkowników w procesach budżetowania (np. bottom-up lub up- -bottom) i raportowania, mechanizmami wyliczania rentowności, marż, prowizji, alokacji, procedury bezpieczeństwa związane z przechowywaniem i przetwarzaniem danych. itp. To wszystko może mieć wpływ na finalny kształt architektury systemu.

A co z danymi?

W tym miejscu warto podkreślić też kwestię wyboru przez organizację modelu hurtowni i procesu dostępu do danych – czy firma chce tworzyć centralną hurtownię korporacyjną, obejmującą wszystkie obszary działalności przedsiębiorstwa, czy też zostawia kwestię systemów raportujących poszczególnym działom w organizacji i pozwala na rozproszenia modelu. Kluczową decyzją jest więc zamodelowanie procesu dostępu do danych i ich ewentualnej integracji.

Szczególnie ważnym elementem analizy przedwdrożeniowej każdego rodzaju systemu BI jest jakość danych źródłowych. Od tego, w jakim stanie są dane źródłowe importowane z systemów transakcyjnych, zależy później jakość analiz dostępnych w naszym rozwiązaniu BI. Problem jakości danych źródłowych istniał już w czasach klasycznych systemów BI. Wtedy, a również i teraz, gdy tego typu narzędzia w dalszym ciągu dobrze się sprzedają, nieodzownym etapem wdrożenia była faza czyszczenia danych. Polegała ona na usunięciu wszelkich braków i niejednoznaczności, które mogą być przyczyną błędów w interpretacji wyników analizowanego zjawiska. Jeżeli zatem skłaniamy się ku systemom BI klasy „In-Memory”, nie ulegajmy zbyt pochopnie magii słów o krótkim czasie wdrożenia i koniecznie zadbajmy o jakość danych zgromadzonych w naszych systemach źródłowych.

Na rynku są sprawdzone metody zapewnienia odpowiedniej jakości tych danych, warto więc poświęcić dodatkowy czas na usunięcie wszelkich nieprawidłowości i niejednoznaczności, np. w nazewnictwie produktów, klientów, adresów, nazwach miast, formatach daty, systemach walutowych czy innych miarach stosowanych do opisania zasobów naszej firmy. Dobrą praktyką jest przygotowanie danych dla analiz w systemach „In-Memory” w klasycznym relacyjnym repozytorium, w którym dokonamy wszystkich operacji czyszczenia danych, tak aby informacje przekazywane do pamięci operacyjnej były już zweryfikowane pod kątem spójności, czystości i jednoznaczności.

W wielkich, międzynarodowych korporacjach, instytucjach finansowych czy telekomach liczba transakcji, które są ewidencjonowane każdego dnia, sprawia, że architektura BI korzystająca z systemów OLAP i centralnej hurtowni danych ciągle ma przewagę nad systemami „In-Memory”. W wypadku takich podmiotów ważne są również wspominane wcześniej organizacja procesów biznesowych oraz polityka bezpieczeństwa przechowywania i przetwarzania danych. To one w znacznym stopniu determinują kształt architektury systemów informatycznych przedsiębiorstwa. Jednak i tutaj systemy „In-Memory” sprawdzają się doskonale. Pełnią one wówczas funkcję tzw. datamartów, czyli czegoś na kształt minihurtowni danych, połączonych bezpośrednio z korporacyjnymi hurtowniami danych.

Źródło: www.domdata.pl

W tego typu systemach nacisk położony jest na wydajność i moc obliczeniową centralnego miejsca, czyli serwera OLAP, do którego podłączeni są poszczególni użytkownicy. Wszelkie operacje odbywają właśnie na centralnym serwerze, a jego klienci otrzymują dane już przetworzone, np. w formie różnych analiz: raportów, tabel przestawnych itp.

Taka architektura sprawia, że w praktyce nie ma wielkiego znaczenia, jaką mocą obliczeniową dysponują komputery użytkowników końcowych. Ten model systemów Business Intelligence bazujących na technologii OLAP ma ścisły związek z historią rozwoju sprzętu komputerowego. Powstał on w czasach, gdy tylko potężne serwery, np. komputery klasy mainframe, były w stanie poradzić sobie z szybkim przetwarzaniem ogromnych ilości danych i takie operacje były nie do pomyślenia w przypadku komputerów osobistych.

Dziś sytuacja zmieniła się diametralnie. Współczesne pecety niejednokrotnie przewyższają mocą obliczeniową dawne serwery i z powodzeniem są w stanie poradzić sobie z większością zadań, jakie wykonują użytkownicy systemów klasy BI. Ten fakt leży u podstaw powstania nowej generacji systemów Business Intelligence, tzw. systemów „In-Memory”, których architektura pozwala na przetwarzanie danych właśnie w pamięci operacyjnej komputerów osobistych. Czy to oznacza, że można połączyć system BI „In-Memory” z dowolnym systemem transakcyjnym? Teoretycznie tak.

W praktyce bywa nieco inaczej i ma to związek z efektywnością zarządzania zasobami firmy. Aby maksymalizować efektywność gospodarowania zasobami, nie ma zazwyczaj sensu, aby cała zawartość bazy danych źródłowego systemu transakcyjnego (firmowy ERP, CRM czy inny przeznaczony do obsługi konkretnego obszaru funkcjonalnego system) była ładowana do pamięci stacji roboczych wszystkich użytkowników systemu BI. Trafiają tam tylko dane źródłowe z obszarów, które interesują poszczególne osoby: np. sprzedaż, koszty, stany magazynowe, klienci itp.

Opisując w dużym uproszczeniu, menedżer, który chce analizować wybrane obszary działalności firmy, otrzymuje na swój komputer odpowiedni zakres danych i na jego podstawie może prowadzić dowolne analizy, generować raporty, sprawdzać wybrane wskaźniki ekonomiczne itp. Nie potrzebuje do tego celu mocy obliczeniowej serwera, tak jak to miało miejsce w systemach korzystających z architektury opartej na technologii OLAP.

Kryteria wyboru

Niewątpliwie systemy klasy „In-Memory” cieszą się coraz większym zainteresowaniem. Spory wpływ na to mają takie czynniki, jak coraz niższe ceny sprzętu, w tym kluczowej dla tego typu systemów BI pamięci RAM, oraz wydajniejsze (i również coraz tańsze) procesory. Dzięki temu udaje się osiągnąć stosunkowo krótki czas implementacji systemów BI typu „In-Memory” oraz niższe koszty związanych z nimi usług wdrożeniowych. Stając przed wyborem typu systemu Business Intelligence, trzeba jednak bardzo dokładnie rozważyć kilka dodatkowych kwestii.

Oszczędności w budżecie i czasie potrzebnym na wdrożenie to bardzo atrakcyjne korzyści, jednak, podobnie jak w wypadku wdrożeń systemów transakcyjnych, nie tylko one decydują o powodzeniu całego przedsięwzięcia. Bardzo ważne są również przeznaczenie systemu, liczba i lokalizacja użytkowników, organizacja procesów biznesowych czy choćby ilość i jakość danych źródłowych. W przypadku pierwszego elementu, czyli przeznaczenia systemu, chodzi o to, czy potrzebujemy narzędzia tylko do analiz, czy też może do budżetowania, raportowania i zaawansowanych symulacji np. z wykorzystaniem statystyki. Do tego dochodzi kwestia zakresu tych zastosowań, to znaczy, czy analizujemy i prognozujemy tylko wybrany wycinek z działalności naszej firmy, czy też zajmujemy się kompleksowo wszystkimi obszarami aktywności gospodarczej.

Z kolei liczba i lokalizacja użytkowników, zwłaszcza w powiązaniu z ich funkcją w organizacji, firmowym obiegiem informacji i wymaganiami odnośnie aktualności danych determinuje sposób pracy z systemem BI. Chodzi tu o pracę z aplikacją (tzw. gruby klient) w trybie przeglądarkowym, zintegrowanym z systemem BI arkuszem kalkulacyjnym, ewentualnie pracą w trybie off-line, na wybranej porcji danych – tzw. kostce lub kostkach lokalnych, które replikowane są z hurtownią/repozytorium systemu co określony interwał czasu lub na żądanie. Lokalizacja i infrastruktura mają też wpływ na to, czy będzie istniała możliwość przesyłania ze źródła dość znaczącej ilości danych i jak długo będzie to trwało. W tym wypadku duże znaczenie ma chociażby przepustowość dostępnych łączy internetowych.

Organizacja procesów biznesowych to zwykle kwestie związane z funkcjami poszczególnych użytkowników w procesach budżetowania (np. bottom-up lub up- -bottom) i raportowania, mechanizmami wyliczania rentowności, marż, prowizji, alokacji, procedury bezpieczeństwa związane z przechowywaniem i przetwarzaniem danych. itp. To wszystko może mieć wpływ na finalny kształt architektury systemu.

A co z danymi?

W tym miejscu warto podkreślić też kwestię wyboru przez organizację modelu hurtowni i procesu dostępu do danych – czy firma chce tworzyć centralną hurtownię korporacyjną, obejmującą wszystkie obszary działalności przedsiębiorstwa, czy też zostawia kwestię systemów raportujących poszczególnym działom w organizacji i pozwala na rozproszenia modelu. Kluczową decyzją jest więc zamodelowanie procesu dostępu do danych i ich ewentualnej integracji.

Szczególnie ważnym elementem analizy przedwdrożeniowej każdego rodzaju systemu BI jest jakość danych źródłowych. Od tego, w jakim stanie są dane źródłowe importowane z systemów transakcyjnych, zależy później jakość analiz dostępnych w naszym rozwiązaniu BI. Problem jakości danych źródłowych istniał już w czasach klasycznych systemów BI. Wtedy, a również i teraz, gdy tego typu narzędzia w dalszym ciągu dobrze się sprzedają, nieodzownym etapem wdrożenia była faza czyszczenia danych. Polegała ona na usunięciu wszelkich braków i niejednoznaczności, które mogą być przyczyną błędów w interpretacji wyników analizowanego zjawiska. Jeżeli zatem skłaniamy się ku systemom BI klasy „In-Memory”, nie ulegajmy zbyt pochopnie magii słów o krótkim czasie wdrożenia i koniecznie zadbajmy o jakość danych zgromadzonych w naszych systemach źródłowych.

Na rynku są sprawdzone metody zapewnienia odpowiedniej jakości tych danych, warto więc poświęcić dodatkowy czas na usunięcie wszelkich nieprawidłowości i niejednoznaczności, np. w nazewnictwie produktów, klientów, adresów, nazwach miast, formatach daty, systemach walutowych czy innych miarach stosowanych do opisania zasobów naszej firmy. Dobrą praktyką jest przygotowanie danych dla analiz w systemach „In-Memory” w klasycznym relacyjnym repozytorium, w którym dokonamy wszystkich operacji czyszczenia danych, tak aby informacje przekazywane do pamięci operacyjnej były już zweryfikowane pod kątem spójności, czystości i jednoznaczności.

W wielkich, międzynarodowych korporacjach, instytucjach finansowych czy telekomach liczba transakcji, które są ewidencjonowane każdego dnia, sprawia, że architektura BI korzystająca z systemów OLAP i centralnej hurtowni danych ciągle ma przewagę nad systemami „In-Memory”. W wypadku takich podmiotów ważne są również wspominane wcześniej organizacja procesów biznesowych oraz polityka bezpieczeństwa przechowywania i przetwarzania danych. To one w znacznym stopniu determinują kształt architektury systemów informatycznych przedsiębiorstwa. Jednak i tutaj systemy „In-Memory” sprawdzają się doskonale. Pełnią one wówczas funkcję tzw. datamartów, czyli czegoś na kształt minihurtowni danych, połączonych bezpośrednio z korporacyjnymi hurtowniami danych.

Źródło: www.domdata.pl

Najnowsze wiadomości

Customer-specific AI: dlaczego w 2026 roku to ona przesądza o realnym wpływie AI na biznes

W 2026 roku sztuczna inteligencja przestaje być ciekawostką technologiczną, a zaczyna być rozliczana z realnego wpływu na biznes. Organizacje oczekują dziś decyzji, którym można zaufać, procesów działających przewidywalnie oraz doświadczeń klientów, które są spójne w skali. W tym kontekście coraz większe znaczenie zyskuje customer-specific AI - podejście, w którym inteligencja jest osadzona w danych, procesach i regułach konkretnej firmy, a nie oparta na generycznych, uśrednionych modelach.

PROMAG S.A. rozpoczyna wdrożenie systemu ERP IFS Cloud we współpracy z L-Systems

PROMAG S.A., lider w obszarze intralogistyki, rozpoczął wdrożenie systemu ERP IFS Cloud, który ma wesprzeć dalszy rozwój firmy oraz integrację kluczowych procesów biznesowych. Projekt realizowany jest we współpracy z firmą L-Systems i obejmuje m.in. obszary finansów, produkcji, logistyki, projektów oraz serwisu, odpowiadając na rosnącą skalę i złożoność realizowanych przedsięwzięć.

SkyAlyne stawia na IFS dla utrzymania floty RCAF

SkyAlyne, główny wykonawca programu Future Aircrew Training (FAcT), wybrał IFS Cloud for Aviation Maintenance jako cyfrową platformę do obsługi technicznej lotnictwa i zarządzania majątkiem. Wdrożenie ma zapewnić wgląd w czasie rzeczywistym w utrzymanie floty, zasoby i zgodność, ograniczyć przestoje oraz zwiększyć dostępność samolotów szkoleniowych RCAF w skali całego kraju. To ważny krok w modernizacji kanadyjskiego systemu szkolenia załóg lotniczych.

Wykorzystanie AI w firmach rośnie, ale wolniej, niż oczekiwano. Towarzyszy temu sporo rozczarowań

Wykorzystanie sztucznej inteligencji w firmach rośnie, ale tempo realnych wdrożeń pozostaje znacznie wolniejsze od wcześniejszych oczekiwań rynku. Dane pokazują, że z rozwiązań AI korzysta dziś wciąż niewiele przedsiębiorstw, a menedżerowie coraz częściej wskazują na bariery regulacyjne, koszty oraz brak powtarzalnych efektów biznesowych. W praktyce technologia jest testowana głównie w wybranych obszarach, a kluczowe decyzje nadal pozostają po stronie człowieka. Również w firmach, które wdrożyły AI, nierzadko towarzyszą temu rozczarowania.

Europejski przemysł cyfryzuje się zbyt wolno – ERP, chmura i AI stają się koniecznością

Europejski przemysł średniej wielkości wie, że cyfryzacja jest koniecznością, ale wciąż nie nadąża za tempem zmian. Ponad 60% firm ocenia swoje postępy w transformacji cyfrowej jako zbyt wolne, mimo rosnącej presji konkurencyjnej, regulacyjnej i kosztowej. Raport Forterro pokazuje wyraźną lukę między świadomością potrzeby inwestycji w chmurę, ERP i AI a realną zdolnością do ich wdrożenia – ograniczaną przez braki kompetencyjne, budżety i gotowość organizacyjną.

Europejski przemysł średniej wielkości wie, że cyfryzacja jest koniecznością, ale wciąż nie nadąża za tempem zmian. Ponad 60% firm ocenia swoje postępy w transformacji cyfrowej jako zbyt wolne, mimo rosnącej presji konkurencyjnej, regulacyjnej i kosztowej. Raport Forterro pokazuje wyraźną lukę między świadomością potrzeby inwestycji w chmurę, ERP i AI a realną zdolnością do ich wdrożenia – ograniczaną przez braki kompetencyjne, budżety i gotowość organizacyjną.

Najnowsze artykuły

5 pułapek zarządzania zmianą, które mogą wykoleić transformację cyfrową i wdrożenie ERP

Dlaczego jedne wdrożenia ERP dowożą korzyści, a inne kończą się frustracją, obejściami w Excelu i spadkiem zaufania do systemu? Najczęściej decyduje nie technologia, lecz to, jak organizacja prowadzi zmianę: czy liderzy biorą odpowiedzialność za decyzje czy tempo jest dopasowane do zdolności absorpcji oraz czy ludzie dostają klarowność ról i realne kompetencje. Do tego dochodzi pytanie: co po go-live - stabilizacja czy chaos w firmie? Poniżej znajdziesz 5 pułapek, które najczęściej wykolejają transformację i praktyczne sposoby, jak im zapobiec.

SAP vs Oracle vs Microsoft: jak naprawdę wygląda chmura i sztuczna inteligencja w ERP

Wybór systemu ERP w erze chmury i sztucznej inteligencji to decyzja, która determinuje sposób działania organizacji na lata — a często także jej zdolność do skalowania, adaptacji i realnej transformacji cyfrowej. SAP, Oracle i Microsoft oferują dziś rozwiązania, które na pierwszy rzut oka wyglądają podobnie, lecz w praktyce reprezentują zupełnie odmienne podejścia do chmury, AI i zarządzania zmianą. Ten artykuł pokazuje, gdzie kończą się deklaracje, a zaczynają realne konsekwencje biznesowe wyboru ERP.

Transformacja cyfrowa z perspektywy CFO: 5 rzeczy, które przesądzają o sukcesie (albo o kosztownej porażce)

Transformacja cyfrowa w finansach często zaczyna się od pytania o ERP, ale w praktyce rzadko sprowadza się wyłącznie do wyboru systemu. Dla CFO kluczowe jest nie tylko „czy robimy pełną wymianę ERP”, lecz także jak policzyć ryzyko operacyjne po uruchomieniu, ocenić wpływ modelu chmurowego na koszty OPEX oraz utrzymać audytowalność i kontrolę wewnętrzną w nowym modelu działania firmy.

Agentic AI rewolucjonizuje HR i doświadczenia pracowników

Agentic AI zmienia HR: zamiast odpowiadać na pytania, samodzielnie realizuje zadania, koordynuje procesy i podejmuje decyzje zgodnie z polityką firmy. To przełom porównywalny z transformacją CRM – teraz dotyczy doświadczenia pracownika. Zyskują HR managerowie, CIO i CEO: mniej operacji, więcej strategii. W artykule wyjaśniamy, jak ta technologia redefiniuje rolę HR i daje organizacjom przewagę, której nie da się łatwo nadrobić.

Composable ERP: Przewodnik po nowoczesnej architekturze biznesowej

Czy Twój system ERP nadąża za tempem zmian rynkowych, czy stał się cyfrową kotwicą hamującą rozwój? W dobie nieciągłości biznesowej tradycyjne monolity ustępują miejsca elastycznej architekturze Composable ERP. To rewolucyjne podejście pozwala budować środowisko IT z niezależnych modułów (PBC) niczym z klocków, zapewniając zwinność nieosiągalną dla systemów z przeszłości. W tym raporcie odkryjesz, jak uniknąć pułapki długu technologicznego, poznasz strategie liderów rynku (od SAP po MACH Alliance) i wyciągniesz lekcje z kosztownych błędów gigantów takich jak Ulta Beauty. To Twój strategiczny przewodnik po transformacji z cyfrowego "betonu" w adaptacyjną "plastelinę".

Oferty Pracy

-

Młodszy konsultant programista Microsoft Dynamics 365 Business Central

-

Konsultant programista Microsoft Dynamics 365 Business Central

-

Konsultant Microsoft Dynamics 365

-

Konsultant Wdrożeniowy Symfonia – księgowość

-

Microsoft Fabric Engineer (MFE)

-

Data/Business Analyst (PBI/Fabric)

-

CRM consultant

-

Starszy architekt systemów rozproszonych

-

Inżynier Zastosowań AI

Przeczytaj Również

Real-Time Intelligence – od trendu do biznesowego must-have

Sposób prowadzenia działalności gospodarczej dynamicznie się zmienia. Firmy muszą stale dostosowywa… / Czytaj więcej

EPM – co to jest? Czy jest alternatywą dla BI?

Nowoczesne systemy BI i EPM dostarczają wiedzy potrzebnej do efektywnego zarządzania firmą. Czy zna… / Czytaj więcej

W jaki sposób firmy zwiększają swoją odporność na zmiany?

Do zwiększenia odporności na zmiany, konieczna jest pełna kontrola nad codziennymi procesami zapewn… / Czytaj więcej

Dlaczego systemy kontrolingowe są potrzebne współczesnym firmom?

Narzędzia Corporate Performance Management (CPM) pozwalają na przyśpieszenie tempa podejmowania dec… / Czytaj więcej

Hurtownie danych – funkcje i znaczenie dla BI

Przepisów na sukces biznesu jest na rynku wiele. Nie ulega jednak wątpliwości, że jednym z kluczowy… / Czytaj więcej

Po co dane w handlu? Okazuje się, że ich analityka może dać nawet 30 proc. większe zyski!

Jak wynika z badania firmy doradczej Capgemni, producenci FMCG oraz firmy związane z handlem detali… / Czytaj więcej