Business Intelligence: czas stawiać żagle

Katgoria: BUSINESS INTELLIGENCE / Utworzono: 19 czerwiec 2012

Business Intelligence: czas stawiać żagle

Przełom stał się faktem – wyniki ostatnich badań i analiz zaprezentowane przez Gartner Group na BI Summit w lutym b.r. w Londynie potwierdzają, że zapowiadany przełom w dziedzinie Business Intelligence właśnie się dokonał. Top menedżerowie muszą zastanowić się, w jaki sposób ustawić firmowy okręt do nowego wiatru.

Firmy stojące wobec wyzwań gospodarki opartej na informacji znalazły odpowiedź - lawinowo przyrasta liczba firm wdrażających rozwiązania Business Intelligence nowej generacji wykorzystujące asocjacyjne bazy danych in-memory. Wypierane są dominujące dotychczas rozwiązania BI oparte na technologii OLAP, zapewniając użytkownikom biznesowym łatwiejszy i szerszy dostęp do informacji, taniej, szybciej i bardziej elastycznie niż kiedykolwiek. Przełomowość obserwowanych zmian polega na tym, że firmy śmiało przyswajając nowe technologie jednocześnie przebudowują całościowe podejście organizacji do BI – począwszy od metod wdrożeniowych przez demokratyzację informacji a kończąc na nowym podziale kompetencji na linii IT i biznes.

Warto zaznaczyć, że duża popularność nowego podejścia oraz zwiększenie dostępności narzędzi BI nie odbywa się kosztem ich jakości lub wydajności. Nie stanowi także efektu marketingowej ofensywy, a wynika z dowiedzenia skuteczności nowatorskich technologii i metodyk wdrożeniowych. Większa wydajność nowego BI, większa elastyczność, lepszy odbiór przez użytkownika idzie tu paradoksalnie w parze z mniejszymi kosztami wdrożenia, mniejszymi wymagania sprzętowymi. W skrócie - z niższym TCO. Taka sytuacja potwierdza opinie o przełomowym charakterze nowego BI.

Zobaczmy jakie są główne czynniki przełomu:

Warto zaznaczyć, że duża popularność nowego podejścia oraz zwiększenie dostępności narzędzi BI nie odbywa się kosztem ich jakości lub wydajności. Nie stanowi także efektu marketingowej ofensywy, a wynika z dowiedzenia skuteczności nowatorskich technologii i metodyk wdrożeniowych. Większa wydajność nowego BI, większa elastyczność, lepszy odbiór przez użytkownika idzie tu paradoksalnie w parze z mniejszymi kosztami wdrożenia, mniejszymi wymagania sprzętowymi. W skrócie - z niższym TCO. Taka sytuacja potwierdza opinie o przełomowym charakterze nowego BI.

Zobaczmy jakie są główne czynniki przełomu:

- popyt biznesu na informację wynikający z większej niż kiedykolwiek presji na konkurencyjność i efektywność działania; popyt na informację podaną w nowy sposób - łatwo i intuicyjnie dla użytkownika biznesowego, bez oczekiwania, na każde urządzenie i w każdym miejscu; wreszcie popyt na znacznie szerszą i bardziej szczegółową informację integrującą rosnące ilości danych pochodzących z coraz większej liczby systemów źródłowych. Jest to popyt, którego tradycyjna architektura BI nie jest już w stanie zaspokajać.

- dostępność nowej technologii – Business Intelligence nowej generacji to nie tylko lepsze parametry techniczne jak wysoka wydajność, szybkość i elastyczność. Fundamentalne znaczenie dla skuteczności wdrożenia ma efektywność kosztowa. Nowe narzędzia BI, określane często jako Data Discovery wymagają mniejszych nakładów na ich wdrożenie i rozwój, które mogą odbywać się modułowo, w sposób skalowalny i pod kontrolą użytkowników, często w modelu self-service;

- upowszechnienie, wejście nowej technologii do głównego nurtu, o czym świadczą jasno rozmiary rynku Data Discovery, którego wielkość jest oszacowana przez firmę Gartner na 591 mln USD w 2011 r. i prognozowana na 1 mld w 2013; śmiało można powiedzieć, że obawy towarzyszące wprowadzaniu rozwiązań pionierskich nie dotyczą już BI in-memory.

Temat dostępu do aktualnej informacji jest w każdej firmie zdecydowanie tematem interdyscyplinarnym, biznesowym. Informacja pomaga w operacyjnych, codziennych działaniach, pozwala podnosić efektywność firmy, konkurować z resztą rynkowej stawki. Według prognoz cytowanej już firmy Gartner, do 2015 r. odpowiedzialność za decyzje o wyborze narzędzi IT w dużej mierze przejdzie na barki użytkowników biznesowych – szacuje się, że za 3 lata 35% wydatków na technologie informatyczne będzie pochodziło spoza budżetu IT w firmie. Innymi słowy, tzw. menedżerowie biznesowi przejmą odpowiedzialność za wybór, wdrożenie i rozwój systemów BI. W tej sytuacji warto zaprosić każdego top menedżera – CEO, COO, CFO, CIO, CMO - do rozważenia, w jakim stopniu nowa kultura informacyjna jest potrzebna w jego firmie i w podległym mu obszarze.

- Czy dostrzega rosnące zapotrzebowanie na coraz bardziej zróżnicowane informacje i rosnącą trudność ich uzyskania z coraz większej liczby systemów?

- Czy nowy BI dostarczając lepszą jakość informacji może realnie poprawić efektywność i konkurencyjność prowadzonego biznesu?

Nowy popyt na nową informację

Warunki, w których działają firmy można z punktu widzenia dostępu do informacji scharakteryzować najkrócej jako swoisty dyktat potrzeb użytkownika biznesowego, który coraz bardziej zdecydowanie żąda informacji dopasowanej do jego zmiennych potrzeb, dostępnej natychmiast, łatwej, zrozumiałej i docierającej przy użyciu urządzeń mobilnych, w każdym miejscu.

Bez wątpienia jest to w dużym stopniu efekt przemian społecznych, jakie przyniosła w ostatnich latach ekspansja technologii informatycznych w społeczeństwach rozwiniętych. Powszechna dostępność do Internetu, produktów takich firm jak Google i Apple wykształciła u setek milionów ludzi na całym świecie nowe wyobrażenie o standardzie i ergonomii korzystania z zaawansowanych technologicznie produktów. Według różnych szacunków, ok. 40% aktywnych zawodowo ludzi w USA stanowią przedstawiciele pokolenia, które „wychowało” się na przeglądarce www, iPodzie, tablecie i nie doświadczyło jeszcze innego sposobu obsługi systemów i urządzeń. Dla nich czas oczekiwania na odpowiedź dłuższy niż w Google lub obsługa trudniejsza niż w przypadku iPhona jest trudna do przyjęcia. Nie inaczej jest w Polsce. Dla takich pracowników sytuacja, w której system analityczny jest trudny w obsłudze, często wymagane są wielodniowe szkolenia, na odpowiedź trzeba czekać minutami a informacja często pochodzi sprzed kilku dni jest niezrozumiała i demotywująca.

Nowy popyt na informację wynika także z konieczności rozszerzenia grona odbiorców przetworzonej informacji i analiz w strukturze organizacyjnej przedsiębiorstwa. Coraz większa konkurencyjność, konieczność poprawy jakości obsługi klienta, przede wszystkich poprzez skrócenie czasu obsługi, wymusza na firmach delegację części decyzji biznesowych na coraz niższe struktury, czasami aż do poziomu operacyjnego. Tworzy się potrzeba wspierania procesu decyzji i partycypacji w decyzjach, kolejnych poziomów kierownictwa i pracowników. Ilość sytuacji w których warto podejmować decyzje biorąc pod uwagę całościową efektywność działań rośnie, a technologie dają szansę dokonywania najlepszych wyborów.

Dzieje się tak ze względu na rosnącą liczbę źródeł danych na temat produktów, ich odbioru przez klientów, wszelkich aspektów prowadzenia biznesu. Po stronie konsumenckiej także bowiem dokonała się rewolucja i klient nauczył się, że kupowanie oznacza również interakcję za pośrednictwem kanałów elektronicznych. O marce produktu świadczy sposób i styl, w jaki komunikuje się ze swoimi klientami. To wszystko oznacza wzrost liczby danych, na bazie których można elastycznie reagować na zmieniającą się sytuację rynkową. Z drugiej strony, apetyt rośnie w miarę jedzenia. Rozwój kultury informacyjnej w oparciu o rozwiązania elastyczne i szybkie prowadzi do sprzężenia zwrotnego: raz przekonani do opierania decyzji i działania na informacjach uzyskanych ze skorelowanych w odpowiedni sposób danych wyjściowych, pracownicyużytkownicy dążyć będą do tworzenia nowych zapytań, aby uzyskać informacje pozwalające jeszcze precyzyjniej kierować poczynaniami biznesowymi.

Upowszechnienie dostępu do informacji oznacza zatem jej dostępność na wszelkie platformy komunikacyjne, na rosnącą liczbę poziomów decyzyjnych, uporządkowanej w sposób ułatwiający, automatyzujący podejmowanie przez osobę odpowiedzialną decyzji biznesowej.

Czy do obsługi tych wyzwań nie wystarczą jednak klasyczne rozwiązania BI oparte na technologii OLAP? Z całym przekonaniem można już dziś odpowiedzieć, że niestety nie. Koszt obsługi takiej liczby danych, w nowym, opisanym tu trybie dostępu do informacji jakiego wymaga biznes, jest zdecydowanie wyższy. Co więcej, także pod względem technologicznym obsługa takiego strumienia danych i takiego popytu na informację w starym modelu dobiega szybko kresu swoich możliwości. Dobitnie podkreśla to analiza Gartnera prezentowana podczas tegorocznej edycji konferencji Business Intelligence Summit. Jak wskazuje Gartner, 85% działających obecnie na świecie hurtowni danych w ciągu dwóch lat utraci zdolność dostosowania się do rosnącej ilości danych i nowych potrzeb związanych z ich przetwarzaniem.

Proponujemy, aby w tej sytuacji CxO, top menedżer rozważający potrzeby informacyjne podległego mu obszaru i całej firmy w kontekście jej udziału w nowoczesnej gospodarce, poszukał odpowiedzi na następujące pytania:

Warunki, w których działają firmy można z punktu widzenia dostępu do informacji scharakteryzować najkrócej jako swoisty dyktat potrzeb użytkownika biznesowego, który coraz bardziej zdecydowanie żąda informacji dopasowanej do jego zmiennych potrzeb, dostępnej natychmiast, łatwej, zrozumiałej i docierającej przy użyciu urządzeń mobilnych, w każdym miejscu.

Bez wątpienia jest to w dużym stopniu efekt przemian społecznych, jakie przyniosła w ostatnich latach ekspansja technologii informatycznych w społeczeństwach rozwiniętych. Powszechna dostępność do Internetu, produktów takich firm jak Google i Apple wykształciła u setek milionów ludzi na całym świecie nowe wyobrażenie o standardzie i ergonomii korzystania z zaawansowanych technologicznie produktów. Według różnych szacunków, ok. 40% aktywnych zawodowo ludzi w USA stanowią przedstawiciele pokolenia, które „wychowało” się na przeglądarce www, iPodzie, tablecie i nie doświadczyło jeszcze innego sposobu obsługi systemów i urządzeń. Dla nich czas oczekiwania na odpowiedź dłuższy niż w Google lub obsługa trudniejsza niż w przypadku iPhona jest trudna do przyjęcia. Nie inaczej jest w Polsce. Dla takich pracowników sytuacja, w której system analityczny jest trudny w obsłudze, często wymagane są wielodniowe szkolenia, na odpowiedź trzeba czekać minutami a informacja często pochodzi sprzed kilku dni jest niezrozumiała i demotywująca.

Nowy popyt na informację wynika także z konieczności rozszerzenia grona odbiorców przetworzonej informacji i analiz w strukturze organizacyjnej przedsiębiorstwa. Coraz większa konkurencyjność, konieczność poprawy jakości obsługi klienta, przede wszystkich poprzez skrócenie czasu obsługi, wymusza na firmach delegację części decyzji biznesowych na coraz niższe struktury, czasami aż do poziomu operacyjnego. Tworzy się potrzeba wspierania procesu decyzji i partycypacji w decyzjach, kolejnych poziomów kierownictwa i pracowników. Ilość sytuacji w których warto podejmować decyzje biorąc pod uwagę całościową efektywność działań rośnie, a technologie dają szansę dokonywania najlepszych wyborów.

Dzieje się tak ze względu na rosnącą liczbę źródeł danych na temat produktów, ich odbioru przez klientów, wszelkich aspektów prowadzenia biznesu. Po stronie konsumenckiej także bowiem dokonała się rewolucja i klient nauczył się, że kupowanie oznacza również interakcję za pośrednictwem kanałów elektronicznych. O marce produktu świadczy sposób i styl, w jaki komunikuje się ze swoimi klientami. To wszystko oznacza wzrost liczby danych, na bazie których można elastycznie reagować na zmieniającą się sytuację rynkową. Z drugiej strony, apetyt rośnie w miarę jedzenia. Rozwój kultury informacyjnej w oparciu o rozwiązania elastyczne i szybkie prowadzi do sprzężenia zwrotnego: raz przekonani do opierania decyzji i działania na informacjach uzyskanych ze skorelowanych w odpowiedni sposób danych wyjściowych, pracownicyużytkownicy dążyć będą do tworzenia nowych zapytań, aby uzyskać informacje pozwalające jeszcze precyzyjniej kierować poczynaniami biznesowymi.

Upowszechnienie dostępu do informacji oznacza zatem jej dostępność na wszelkie platformy komunikacyjne, na rosnącą liczbę poziomów decyzyjnych, uporządkowanej w sposób ułatwiający, automatyzujący podejmowanie przez osobę odpowiedzialną decyzji biznesowej.

Czy do obsługi tych wyzwań nie wystarczą jednak klasyczne rozwiązania BI oparte na technologii OLAP? Z całym przekonaniem można już dziś odpowiedzieć, że niestety nie. Koszt obsługi takiej liczby danych, w nowym, opisanym tu trybie dostępu do informacji jakiego wymaga biznes, jest zdecydowanie wyższy. Co więcej, także pod względem technologicznym obsługa takiego strumienia danych i takiego popytu na informację w starym modelu dobiega szybko kresu swoich możliwości. Dobitnie podkreśla to analiza Gartnera prezentowana podczas tegorocznej edycji konferencji Business Intelligence Summit. Jak wskazuje Gartner, 85% działających obecnie na świecie hurtowni danych w ciągu dwóch lat utraci zdolność dostosowania się do rosnącej ilości danych i nowych potrzeb związanych z ich przetwarzaniem.

Proponujemy, aby w tej sytuacji CxO, top menedżer rozważający potrzeby informacyjne podległego mu obszaru i całej firmy w kontekście jej udziału w nowoczesnej gospodarce, poszukał odpowiedzi na następujące pytania:

- Czy w firmie odczuwany jest popyt na informację?

- Czy forma i tryb dostarczania informacji potrzebnej do podejmowania decyzji nie tłumi tego popytu?

- Czy zarząd firmy dostrzega korzyści z szybkiego i powszechnego dostępu do informacji biznesowej, potrzebnej do decyzji taktycznych, operacyjnych i strategicznych?

Nowe imię BI

Pojawieniu się i upowszechnieniu nowych narzędzi BI towarzyszy zmiana świadomości klientów co do rynku dostawców BI. Po długich latach dominacji tzw. mega-dostawców, paradoksalnie to mniejsi, dużo bardziej innowacyjni dostawcy zaczęli wyznaczać nowe trendy. Zdaniem Gartnera, to właśnie dostawcy BI in-memory wyznaczyli nowy standard wydajności i elastyczności narzędzi analitycznych, którym podążać zaczynają teraz wielcy producenci tradycyjnych systemów. Część mega-dostawców próbuje wprowadzić na rynek produkty w całości oparte o in-memory inni skupiają się jedynie na przyspieszeniu starych rozwiązań tworząc konstrukcje hybrydowe, jeszcze inni uruchomili machiny marketingowe promujące innowacyjne rozwiązania, których de facto nie mają jeszcze w swojej ofercie. W powszechnej ocenie są to jednak działania o wiele lat spóźnione lub niewystarczające. Dowodzą tego zmiany w preferencjach użytkowników BI. Wg danych Gartner Group na przestrzeni ostatnich 3 lat nastąpił zdecydowany, sięgający w niektórych wypadkach 20%, spadek wyboru produktów mega-dostawców jako standardu platformy BI w firmach na całym świecie.

Narzędzia BI nowej generacji to nie tylko wysoka wydajność. Korzyścią nie mniej ważną co możliwość przetworzenia milionów danych w ułamkach sekund jest elastyczność całego modelu analitycznego. Elastyczność to możliwość stopniowego i ewolucyjnego dostosowania całego systemu raportowania do zmieniających się wymagań użytkownika a także zmieniających się w tle systemów informatycznych. Z tych względów we wdrażaniu nowego BI coraz częściej wybierane jest podejście agile. Pozwala to na stopniowe wprowadzanie BI, w obszarach, gdzie najszybciej nastąpi zwrot z poniesionych nakładów. Dzięki stosowaniu lekkiej metodyki oraz krótszych i mniej sformalizowanych projektów czas osiągania korzyści jest krótszy a koszty mniejsze. Stopniowo rozbudowywane BI nowego typu może obejmować całość organizacji i jej procesów, przyczyniając się do generowania wartości z oparcia całego biznesu na informacji, która jest precyzyjnie dopasowana do chwilowych i długofalowych potrzeb. Rozwinięciem takiej filozofii jest podejście self-service, promowane przez dostawców BI in-memory. Dzięki prostocie rozwiązania i przystosowaniu do pracy z użytkownikami biznesowymi firma może łatwo wykształcić kompetencje oraz entuzjazm do dalszego rozwijania, przystosowywania i zmieniania rozwiązania Business Intelligence całkowicie we własnym zakresie. W jego rozwój angażują się ci, którzy najwięcej mogą na tym zyskać: sami pracownicy. Dzięki temu system analityczny jest rozwiązaniem, które żyje, zmienia się wraz z firmą, odzwierciedla sposób, w jaki prowadzony jest biznes. Pozwala także prognozować rozwój sytuacji i w odpowiedni sposób dostrajać do niej procesy.

Przymierzając możliwości, jakie przynosi BI in-memory i możliwości jego integracji z procesami firmy i jej modelem biznesowym, warto z perspektywy top menedżera zastanowić się:

- Czy strategia firmy zakłada wykorzystanie technologii BI do przełamywania trudności i osiągania pozycji lidera w rynkowej niszy?

- Kto odpowiada za wydatki na rozwiązania IT, a szczególności narzędzia wspierające podejmowanie decyzji, analizę danych?

- Czy procedury i kryteria wyboru narzędzi BI uwzględniają najnowsze światowe trendy technologiczne i biznesowe?

Nowy BI w głównym nurcie

Z formalnego punktu widzenia, zmianę na rynku potwierdza uzyskanie rynkowej masy krytycznej przez rozwiązania BI In-memory. Według obliczeń firmy Gartner, w ub. roku wartość rynku BI In-memory (w nomenklaturze Gartnera ten typ rozwiązań to Data Discovery) wyniosła blisko 600 mln dolarów, w 2013 r. przekroczy 1 mld dolarów, a w 2015 – 1,6 mld dolarów (dla porównania całość rynku platform analitycznych warta była w 2010 r. 10 mld dolarów).

Sytuacja na rynku BI odzwierciedla obserwowaną także w innych obszarach IT ewolucję rozwiązań informatycznych. To kolejny obszar, gdzie z racji swoich możliwości – wydajności i ergonomii, do głosu dochodzą rozwiązania projektowane jako produkty konsumenckie. W przypadku Business Intelligence, systemy pierwszej generacji w technologii OLAP i bazujące na nich do dziś wielkie rozwiązania od czołowych dostawców tradycyjnego rynku BI przetwarzały dane w sztywnych, z góry określonych strukturach i z wykorzystaniem hurtowni zasilanych danymi z systemów typu ERP, CRM. Punktem ciężkości w tym modelu jest technologia a nie trudno zaspokajalne potrzeby użytkownika. Novum w narzędziach in-memory jest możliwość prostego przeniesienia danych szczegółowych, często z pominięciem hurtowni, do pamięci operacyjnej serwera i swobodna możliwość zadawania przez użytkowników biznesowych dowolnych pytań, do których odpowiedzi system wylicza na bieżąco, w ciągu sekund i podaje w atrakcyjnej wizualnie, zrozumiałej formie. Jednocześnie BI in-memory to rozwiązanie zdecydowanie tańsze i szybsze od „klasycznego”– zarówno pod względem czasu oczekiwania na odpowiedź, jak też ze względu na czas wdrożenia. Radykalne uproszczenie procesu ładowania danych i modelowania prezentacji danych powoduje, że środek ciężkości nowego BI przesuwa się zdecydowanie w kierunku biznesu i właśnie ten fakt jest w opinii wielu obserwatorów jednym z głównych czynników jego sukcesu.

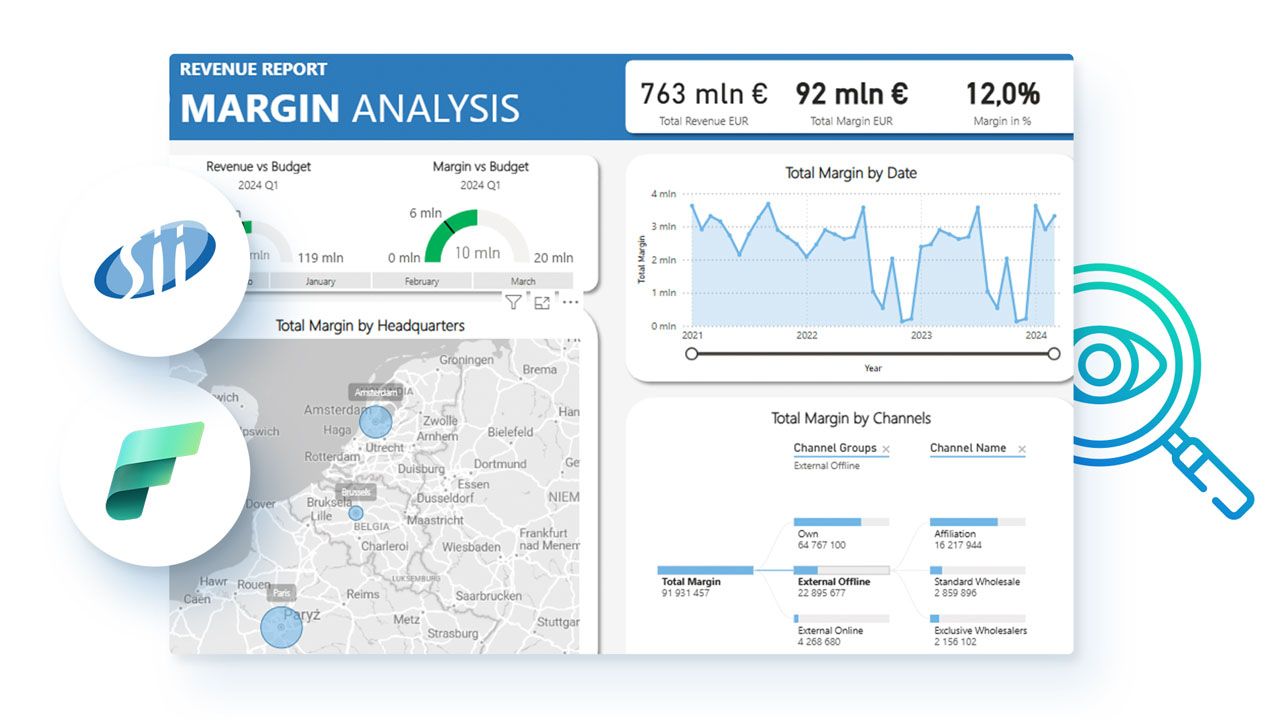

Warto zauważyć, że obecnie rynek nowego BI różni się wyraźnie od rynku tradycyjnego BI. O ile ten ostatni podzielony został pomiędzy kilku potężnych graczy, to na rynku BI In-Memory mamy do czynienia z wyraźną dominacją jednego z pionierów tej technologii, amerykańskiej firmy o skandynawskich korzeniach - QlikTech. QlikView, ich sztandarowe rozwiązania, posiada obecnie ok. 40-proc. udział w światowym rynku Data Discovery. Jest to pionierska platforma analityczna oparta o koncepcję asocjacyjnej bazy in-memory rozwijana od 1993 r. W lutym br. Gartner ogłosił, że QlikView ponownie uplasował się w segmencie liderów BI. Od 2007 r. QlikView jest obecny także na polskim rynku dzięki współpracy z firmą Hogart Business Intelligence. Firma ta ma na swoim koncie szereg, bardzo zróżnicowanych wdrożeń z różnych sektorów i segmentów polskiej gospodarki. Dowodzi to uniwersalnego charakteru rozwiązania i uniwersalności potrzeb, przed którymi stoją firmy. Łączy je jednak zarazem kilka wspólnych cech: firmy, które zdecydowały się na wdrożenie nowoczesnego BI mają wysoką świadomość potrzeb użytkowników biznesowych, stawiają na szybkość uzyskania zwrotu z inwestycji oraz często zmagają się z problemem słabej wydajności na dużych ilościach danych. W praktyce projektowej oznaczało to nie tylko krótki czas wdrożenia, ale także krótki czas przyswojenia sobie pracy w tym środowisku przez użytkowników. I wreszcie – zarządzający w doborze BI kierowali się dążeniem do wytworzenia w firmie nowego podejścia do biznesu, nowej kultury organizacyjnej zorientowanej na podejmowanie świadomych decyzji w oparciu o rzetelną i łatwo dostępną informację. Tylko dając do niej łatwy dostęp, inspirujący do kreowania biznesu, widzieli szansę na uczynienie z informacji jednego z kluczowych czynników konkurencyjności swoich firm.

Ostatnia seria propozycji pytań pod rozwagę top menedżera, przed przystąpieniem do analizy potrzeb zarządzania informacją w firmie, dotyczy bezpośrednio rozwiązań In-Memory. Nie jest to już dziedzina pionierów, nastąpił czas followerów. Ryzyko jest mniejsze. Nadal można dużo uzyskać, aplikując całościowo lub punktowo, ewolucyjnie podejście do zarządzania, jakie stwarzają nowe rozwiązania BI.

- W jakim stopniu CIO i departamentowi IT znane są rozwiązania BI In-memory?

- Jaka jest dojrzałość / poziom ewolucji rozwiązań BI lub pre-BI w firmie?

- Czy można łatwo sklasyfikować role i potrzeby informacyjne pracowników ze względu na miejsce w organizacji, funkcje itd.?

- Czy dostęp do informacji w trybie BI nowej generacji można zaliczyć do czynników sukcesu w krótkim i dłuższym horyzoncie czasowym?

Autor: Marek Grzybek - Dyrektor Zarządzający HOGART BUSINESS INTELLIGENCE

Zarządza pionem rozwiązań Business Intelligence opartym o najnowszą generację narzędzi analitycznych QlikView.

Współtworzył koncepcję wprowadzenia produktu QlikView na polski rynek, definiował strategię sprzedaży dla tego rozwiązania, a także doprowadził do podpisania kilku najpoważniejszych kontraktów wdrożeniowych QlikView w Polsce. Związany z firmą Hogart od 1996, początkowo kierował działem rozwoju oprogramowania i wsparcia technicznego dla produktów Oracle/JDEdwards. Zyskał wieloletnie doświadczenie w zarządzaniu projektami IT w firmach polskich i międzynarodowych, a także w dziedzinie rozwoju aplikacji oraz narzędzi analityczno-raportowych. Wcześniej pracował dla firmy Cordat jako projektant oprogramowania. Absolwent Wydziału Zarządzania Akademii Ekonomicznej w Krakowie.

Najnowsze wiadomości

Customer-specific AI: dlaczego w 2026 roku to ona przesądza o realnym wpływie AI na biznes

W 2026 roku sztuczna inteligencja przestaje być ciekawostką technologiczną, a zaczyna być rozliczana z realnego wpływu na biznes. Organizacje oczekują dziś decyzji, którym można zaufać, procesów działających przewidywalnie oraz doświadczeń klientów, które są spójne w skali. W tym kontekście coraz większe znaczenie zyskuje customer-specific AI - podejście, w którym inteligencja jest osadzona w danych, procesach i regułach konkretnej firmy, a nie oparta na generycznych, uśrednionych modelach.

PROMAG S.A. rozpoczyna wdrożenie systemu ERP IFS Cloud we współpracy z L-Systems

PROMAG S.A., lider w obszarze intralogistyki, rozpoczął wdrożenie systemu ERP IFS Cloud, który ma wesprzeć dalszy rozwój firmy oraz integrację kluczowych procesów biznesowych. Projekt realizowany jest we współpracy z firmą L-Systems i obejmuje m.in. obszary finansów, produkcji, logistyki, projektów oraz serwisu, odpowiadając na rosnącą skalę i złożoność realizowanych przedsięwzięć.

SkyAlyne stawia na IFS dla utrzymania floty RCAF

SkyAlyne, główny wykonawca programu Future Aircrew Training (FAcT), wybrał IFS Cloud for Aviation Maintenance jako cyfrową platformę do obsługi technicznej lotnictwa i zarządzania majątkiem. Wdrożenie ma zapewnić wgląd w czasie rzeczywistym w utrzymanie floty, zasoby i zgodność, ograniczyć przestoje oraz zwiększyć dostępność samolotów szkoleniowych RCAF w skali całego kraju. To ważny krok w modernizacji kanadyjskiego systemu szkolenia załóg lotniczych.

Wykorzystanie AI w firmach rośnie, ale wolniej, niż oczekiwano. Towarzyszy temu sporo rozczarowań

Wykorzystanie sztucznej inteligencji w firmach rośnie, ale tempo realnych wdrożeń pozostaje znacznie wolniejsze od wcześniejszych oczekiwań rynku. Dane pokazują, że z rozwiązań AI korzysta dziś wciąż niewiele przedsiębiorstw, a menedżerowie coraz częściej wskazują na bariery regulacyjne, koszty oraz brak powtarzalnych efektów biznesowych. W praktyce technologia jest testowana głównie w wybranych obszarach, a kluczowe decyzje nadal pozostają po stronie człowieka. Również w firmach, które wdrożyły AI, nierzadko towarzyszą temu rozczarowania.

Europejski przemysł cyfryzuje się zbyt wolno – ERP, chmura i AI stają się koniecznością

Europejski przemysł średniej wielkości wie, że cyfryzacja jest koniecznością, ale wciąż nie nadąża za tempem zmian. Ponad 60% firm ocenia swoje postępy w transformacji cyfrowej jako zbyt wolne, mimo rosnącej presji konkurencyjnej, regulacyjnej i kosztowej. Raport Forterro pokazuje wyraźną lukę między świadomością potrzeby inwestycji w chmurę, ERP i AI a realną zdolnością do ich wdrożenia – ograniczaną przez braki kompetencyjne, budżety i gotowość organizacyjną.

Europejski przemysł średniej wielkości wie, że cyfryzacja jest koniecznością, ale wciąż nie nadąża za tempem zmian. Ponad 60% firm ocenia swoje postępy w transformacji cyfrowej jako zbyt wolne, mimo rosnącej presji konkurencyjnej, regulacyjnej i kosztowej. Raport Forterro pokazuje wyraźną lukę między świadomością potrzeby inwestycji w chmurę, ERP i AI a realną zdolnością do ich wdrożenia – ograniczaną przez braki kompetencyjne, budżety i gotowość organizacyjną.

Najnowsze artykuły

5 pułapek zarządzania zmianą, które mogą wykoleić transformację cyfrową i wdrożenie ERP

Dlaczego jedne wdrożenia ERP dowożą korzyści, a inne kończą się frustracją, obejściami w Excelu i spadkiem zaufania do systemu? Najczęściej decyduje nie technologia, lecz to, jak organizacja prowadzi zmianę: czy liderzy biorą odpowiedzialność za decyzje czy tempo jest dopasowane do zdolności absorpcji oraz czy ludzie dostają klarowność ról i realne kompetencje. Do tego dochodzi pytanie: co po go-live - stabilizacja czy chaos w firmie? Poniżej znajdziesz 5 pułapek, które najczęściej wykolejają transformację i praktyczne sposoby, jak im zapobiec.

SAP vs Oracle vs Microsoft: jak naprawdę wygląda chmura i sztuczna inteligencja w ERP

Wybór systemu ERP w erze chmury i sztucznej inteligencji to decyzja, która determinuje sposób działania organizacji na lata — a często także jej zdolność do skalowania, adaptacji i realnej transformacji cyfrowej. SAP, Oracle i Microsoft oferują dziś rozwiązania, które na pierwszy rzut oka wyglądają podobnie, lecz w praktyce reprezentują zupełnie odmienne podejścia do chmury, AI i zarządzania zmianą. Ten artykuł pokazuje, gdzie kończą się deklaracje, a zaczynają realne konsekwencje biznesowe wyboru ERP.

Transformacja cyfrowa z perspektywy CFO: 5 rzeczy, które przesądzają o sukcesie (albo o kosztownej porażce)

Transformacja cyfrowa w finansach często zaczyna się od pytania o ERP, ale w praktyce rzadko sprowadza się wyłącznie do wyboru systemu. Dla CFO kluczowe jest nie tylko „czy robimy pełną wymianę ERP”, lecz także jak policzyć ryzyko operacyjne po uruchomieniu, ocenić wpływ modelu chmurowego na koszty OPEX oraz utrzymać audytowalność i kontrolę wewnętrzną w nowym modelu działania firmy.

Agentic AI rewolucjonizuje HR i doświadczenia pracowników

Agentic AI zmienia HR: zamiast odpowiadać na pytania, samodzielnie realizuje zadania, koordynuje procesy i podejmuje decyzje zgodnie z polityką firmy. To przełom porównywalny z transformacją CRM – teraz dotyczy doświadczenia pracownika. Zyskują HR managerowie, CIO i CEO: mniej operacji, więcej strategii. W artykule wyjaśniamy, jak ta technologia redefiniuje rolę HR i daje organizacjom przewagę, której nie da się łatwo nadrobić.

Composable ERP: Przewodnik po nowoczesnej architekturze biznesowej

Czy Twój system ERP nadąża za tempem zmian rynkowych, czy stał się cyfrową kotwicą hamującą rozwój? W dobie nieciągłości biznesowej tradycyjne monolity ustępują miejsca elastycznej architekturze Composable ERP. To rewolucyjne podejście pozwala budować środowisko IT z niezależnych modułów (PBC) niczym z klocków, zapewniając zwinność nieosiągalną dla systemów z przeszłości. W tym raporcie odkryjesz, jak uniknąć pułapki długu technologicznego, poznasz strategie liderów rynku (od SAP po MACH Alliance) i wyciągniesz lekcje z kosztownych błędów gigantów takich jak Ulta Beauty. To Twój strategiczny przewodnik po transformacji z cyfrowego "betonu" w adaptacyjną "plastelinę".

Oferty Pracy

-

Młodszy konsultant programista Microsoft Dynamics 365 Business Central

-

Konsultant programista Microsoft Dynamics 365 Business Central

-

Konsultant Microsoft Dynamics 365

-

Konsultant Wdrożeniowy Symfonia – księgowość

-

Microsoft Fabric Engineer (MFE)

-

Data/Business Analyst (PBI/Fabric)

-

CRM consultant

-

Starszy architekt systemów rozproszonych

-

Inżynier Zastosowań AI

Przeczytaj Również

Real-Time Intelligence – od trendu do biznesowego must-have

Sposób prowadzenia działalności gospodarczej dynamicznie się zmienia. Firmy muszą stale dostosowywa… / Czytaj więcej

EPM – co to jest? Czy jest alternatywą dla BI?

Nowoczesne systemy BI i EPM dostarczają wiedzy potrzebnej do efektywnego zarządzania firmą. Czy zna… / Czytaj więcej

W jaki sposób firmy zwiększają swoją odporność na zmiany?

Do zwiększenia odporności na zmiany, konieczna jest pełna kontrola nad codziennymi procesami zapewn… / Czytaj więcej

Dlaczego systemy kontrolingowe są potrzebne współczesnym firmom?

Narzędzia Corporate Performance Management (CPM) pozwalają na przyśpieszenie tempa podejmowania dec… / Czytaj więcej

Hurtownie danych – funkcje i znaczenie dla BI

Przepisów na sukces biznesu jest na rynku wiele. Nie ulega jednak wątpliwości, że jednym z kluczowy… / Czytaj więcej

Po co dane w handlu? Okazuje się, że ich analityka może dać nawet 30 proc. większe zyski!

Jak wynika z badania firmy doradczej Capgemni, producenci FMCG oraz firmy związane z handlem detali… / Czytaj więcej