Od BI do „Big Data”

Katgoria: BUSINESS INTELLIGENCE / Utworzono: 11 wrzesień 2012

Od BI do „Big Data”

Wartość, to zdecydowanie najistotniejsza cecha wyróżniająca dla Big Data – zarówno w kontekście kosztu pozyskania technologii, jak i korzyści, jakie organizacje mogą uzyskać w wyniku jej stosowania.

Autor: Tomasz Słoniewski, IDC CEMA

Gdy w listopadzie 2003 roku rozpoczynaliśmy cykl konferencji pod szyldem „IDC Business Intelligence Roadshow”, na sali zgromadziła się garstka entuzjastów i praktyków oraz duża grupa osób zainteresowanych tym nowym, w tamtym czasie, zjawiskiem na rynku IT. Liczba firm oferujących usługi wdrożeniowe tych systemów była niewielka, większość dużych dostawców nie posiadała jeszcze systemów BI w swojej ofercie – fala przejęć specjalizowanych firm miała ruszyć dopiero trzy lata później. Spośród naszych ówczesnych partnerów tylko trzy firmy wciąż działają na rynku pod swoim szyldem – to Microsoft, Microstrategy i SAS Institute. Cognos i Hyperion funkcjonują za to z powodzeniem w strukturach odpowiednio: IBM i Oracle.

Naszym głównym celem w tamtym czasie była edukacja – zapoznać jak największą ilość managerów IT oraz osób odpowiedzialnych za analitykę z nowymi technologiami, możliwościami jakie daje analiza danych z systemów transakcyjnych oraz właściwym wyważeniem potrzeb biznesu i zastosowanych technologii. Próbowaliśmy pokazać, że analiza danych przydaje się nie tylko w wielkich bankach czy firmach telekomunikacyjnych, ale że praktycznie każda firma o pewnym potencjale danych źródłowych może odnieść wymierne korzyści z wdrożenia BI.

Od tamtych czasów minęła prawie dekada. Systemy Business Intelligence (nazywane przez IDC Business Analytics) stały sie powszechnie znanym i wykorzystywanym narzędziem. Wiele firm, nawet relatywnie małych, dostrzega korzyści z zastosowania narzędzi BI i aplikacji analitycznych. Wiedza wdrożeniowa i biznesowo-analityczna jest również dużo bardziej dostępna. Światowy rynek analityki biznesowej ma się wciąż świetnie – prognoza opublikowana w raporcie IDC z czerwca 2012 pt. „Worldwide Business Analytics Software 2012–2016 Forecast and 2011 Vendor Shares” mówi o średniorocznym 10% wzroście na przestrzeni kolejnych 5 lat.

Czy jednak firmy wykorzystały w pełni potencjał tkwiący w BI? Wydaje się, że nie zawsze i nie do końca. I według mnie nie jest to ich wina – po prostu narzędzia, które dotychczas były w użyciu miały określone ograniczenia. Wiele z nich było natury technicznej (wolne przetwarzanie, słaba jakość danych, ograniczona ilość źródeł), inne natury biznesowej (ograniczony krąg odbiorców analiz, opór zarządów przed wykorzystywaniem danych). Wreszcie – systemy BI skupiały się głównie na kwestiach finansowych, tylko w niektórych przypadkach schodziły na inne pola, takie jak systemy billingowe, czy CRM. W wielu przypadkach dane zawarte w systemach analitycznych nie mogły być w pełni wykorzystane ze względu na czas potrzebny na ich przetworzenie i analizę.

Z wyżej wymienionych powodów wiele ciekawych trendów, zjawisk gospodarczych czy zachowań klientów umykało uwadze analityków, czy osób zarządzających firmami. Lekarstwo na te przypadłości pojawiło się wraz z nadejściem idei „Big Data” – czyli rozwiązań do przetwarzania wielkich woluminów danych. Cechą wyróżniającą Big Data jest idea czterech V: Volume (ilość danych), Variety (różnorodność analizowanych danych i informacji), Velocity (przetwarzanie w czasie rzeczywistym) i Value – czyli wartość jaką możemy uzyskać z połączenia wszystkich poprzednio wymienionych czynników.

Volume czyli ilość danych

Gdy myślimy o ilości danych, powinniśmy zdawać sobie sprawę, że jest to pojęcie względne. Dla niektórych sektorów, albo firm dużą ilością będą tera i petabajty, podczas gdy dla innych może to być o rząd wielkości więcej (np. dla biznesów internetowych o dużej skali czy instytucji badawczych). Wiele zależy również od charakteru danych jakie przychodzi nam analizować. Informacje zawarte w ustrukturyzowanych bazach danych mogą być dużo większe w rozmiarze niż np. archiwa poczty elektronicznej, a mimo to ich przeszukiwanie i analiza będą dużo szybsze i mniej skomplikowane. W wielu przypadkach to jednak informacje zawarte w poczcie są dużo bardziej wartościowe dla firmy: mogą zawierać informacje o niezadowolonych klientach, kontrakty, oferty, projekty techniczne itp.). Jednocześnie przeszukiwanie i analiza takich danych potencjalnie nastręcza najwięcej problemów i wymaga relatywnie największej mocy obliczeniowej.

Variety czyli różnorodność danych

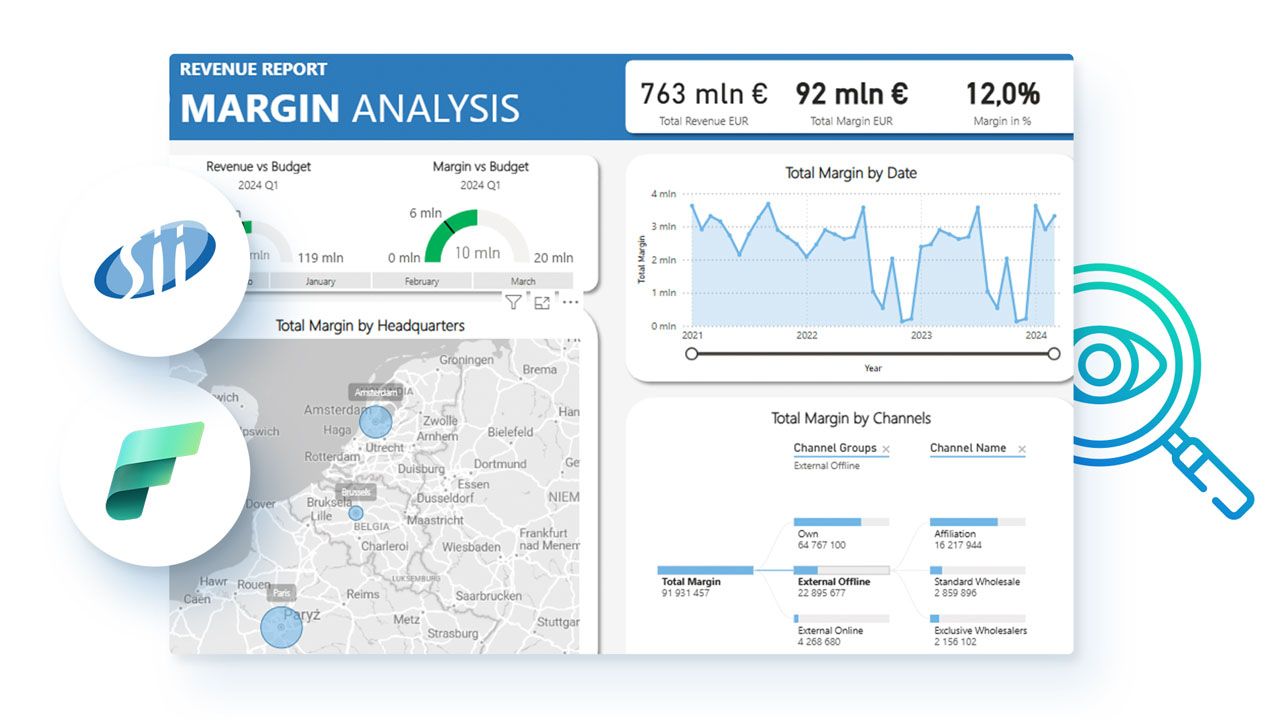

Różnorodność danych poddawanych analizie nie ogranicza się jedynie do podłączenia wielu systemów transakcyjnych. W Big Data chodzi o połączenie wielu typów danych – wspomnianych wcześniej ustrukturyzowanych i nieustrukturyzowanych, wewnętrznych i zewnętrznych, historycznych i aktualnych. Mieszanina taka może być bowiem bardzo interesująca z analitycznego punktu widzenia. Dobrym przykładem mogą być analizy ustrukturyzowanych danych z systemu ERP połączone z danymi geograficznymi i demograficznymi oraz danymi ze strony internetowej. Dzięki temu analityk jest w stanie nie tylko zidentyfikować źródła przychodu i wydajność poszczególnych oddziałów firmy w perspektywie historycznej, ale może zobaczyć dane w szerszym tle: potencjału gospodarczego regionu, statystyk sieciowych i popularności konkretnych produktów na stronie firmowej. Dodatkowo, jeśli system działa w czasie rzeczywistym, biznes może stosować określone promocje w celu poprawy wyników, tudzież promować określone towary na stronie internetowej firmy. Kolejnym przykładem takich połączeń jest choćby analiza danych pogodowych – a zatem danych ustrukturyzowanych ze stacji pogodowych i danych geograficzno-klimatycznych, pochodzących z obserwacji satelitarnych. Możliwość dołączenia tego typu analiz jest jednym z podstawowych kryteriów rozróżnienia między Big Data a klasyczną analityką.

Velocity – czyli szybkość analizy danych

Przetwarzanie danych w organizacjach odbywa się wciąż na różne sposoby – od przetwarzania wsadowego (batch processing) – gdzie dane ładowane są do systemu w określonych interwałach, do ciągłego przepływu danych z systemów transakcyjnych do systemów analitycznych. Chociaż pierwszy ze sposobów jest charakterystyczny dla klasycznych systemów opartych na hurtowniach danych, to w świecie Big Data również jest mocno obecny – właśnie tak dostarczane są dane do przetworzenia w środowisko Hadoop. Podobnie jest w przypadku np. danych pochodzących z inteligentnych liczników energii – porcje danych ładowane są do systemu zazwyczaj co kwadrans. Z kolei ciągły dopływ danych, to domena systemów typu CEP (Complex Event Processing), które są odpowiedzialne za reagowanie na określone zdarzenia, systemów do analizy tekstu i wyszukiwania i innych rozwiązań dedykowanych do automatycznej reakcji na zdarzenia i procesy w środowisku informatycznym (np. wykrywanie nadużyć w bankowości). Kluczami do oceny potrzeb w zakresie szybkości analizy Big Data są procesy biznesowe i wymagania użytkowników. Dobrym przykładem są np. fundusze hedgingowe inwestujące na rynkach światowych – w ich przypadku znaczenie mają ułamki sekund. Z drugiej strony wyszukiwarki sieciowe muszą często „przerobić” ogromne woluminy danych, jednak nie musi to się dokonywać w czasie rzeczywistym. Podsumowując – w Big Data liczy się właściwa informacja dostarczona we właściwym czasie i z właściwym poziomem dokładności.

Value czyli wartość

Wartość, to zdecydowanie najistotniejsza cecha wyróżniająca dla Big Data – zarówno w kontekście kosztu pozyskania technologii, jak i korzyści jakie organizacje mogą uzyskać w wyniku jej stosowania. Koszt technologii jest bardzo istotną różnicą w porównaniu z systemami z przeszłości, ponieważ poszczególne elementy układanki Big Data istniały od lat – tyle, że nie były powszechnie dostępne dla przeciętnej firmy. Wielkie hurtownie danych istniały w sektorze finansowym, telekomunikacyjnym, czy handlu detalicznym. Monitorowanie w czasie rzeczywistym również było obecne na rynku – chociażby w usługach finansowych (trading), przewidywaniu zjawisk pogodowych, czy wykrywaniu nadużyć. Analiza danych nieustrukturyzowanych w zakresie analizy tekstu również nie jest najnowszym wynalazkiem, podobnie jak superkomputery do zastosowań naukowych. To co wyróżnia obecną sytuację, to znacząco niższy koszt pozyskania wysokowydajnych technologii obliczeniowych i analitycznych. Jest to efekt spadających cen sprzętu komputerowego o wysokich parametrach oraz dostępności oprogramowania open source w „chmurze”.

Wartość odnosi się również do korzyści, jakie osiągają firmy i organy administracji w wyniku implementacji Big Data:

Naszym głównym celem w tamtym czasie była edukacja – zapoznać jak największą ilość managerów IT oraz osób odpowiedzialnych za analitykę z nowymi technologiami, możliwościami jakie daje analiza danych z systemów transakcyjnych oraz właściwym wyważeniem potrzeb biznesu i zastosowanych technologii. Próbowaliśmy pokazać, że analiza danych przydaje się nie tylko w wielkich bankach czy firmach telekomunikacyjnych, ale że praktycznie każda firma o pewnym potencjale danych źródłowych może odnieść wymierne korzyści z wdrożenia BI.

Od tamtych czasów minęła prawie dekada. Systemy Business Intelligence (nazywane przez IDC Business Analytics) stały sie powszechnie znanym i wykorzystywanym narzędziem. Wiele firm, nawet relatywnie małych, dostrzega korzyści z zastosowania narzędzi BI i aplikacji analitycznych. Wiedza wdrożeniowa i biznesowo-analityczna jest również dużo bardziej dostępna. Światowy rynek analityki biznesowej ma się wciąż świetnie – prognoza opublikowana w raporcie IDC z czerwca 2012 pt. „Worldwide Business Analytics Software 2012–2016 Forecast and 2011 Vendor Shares” mówi o średniorocznym 10% wzroście na przestrzeni kolejnych 5 lat.

Czy jednak firmy wykorzystały w pełni potencjał tkwiący w BI? Wydaje się, że nie zawsze i nie do końca. I według mnie nie jest to ich wina – po prostu narzędzia, które dotychczas były w użyciu miały określone ograniczenia. Wiele z nich było natury technicznej (wolne przetwarzanie, słaba jakość danych, ograniczona ilość źródeł), inne natury biznesowej (ograniczony krąg odbiorców analiz, opór zarządów przed wykorzystywaniem danych). Wreszcie – systemy BI skupiały się głównie na kwestiach finansowych, tylko w niektórych przypadkach schodziły na inne pola, takie jak systemy billingowe, czy CRM. W wielu przypadkach dane zawarte w systemach analitycznych nie mogły być w pełni wykorzystane ze względu na czas potrzebny na ich przetworzenie i analizę.

Z wyżej wymienionych powodów wiele ciekawych trendów, zjawisk gospodarczych czy zachowań klientów umykało uwadze analityków, czy osób zarządzających firmami. Lekarstwo na te przypadłości pojawiło się wraz z nadejściem idei „Big Data” – czyli rozwiązań do przetwarzania wielkich woluminów danych. Cechą wyróżniającą Big Data jest idea czterech V: Volume (ilość danych), Variety (różnorodność analizowanych danych i informacji), Velocity (przetwarzanie w czasie rzeczywistym) i Value – czyli wartość jaką możemy uzyskać z połączenia wszystkich poprzednio wymienionych czynników.

Volume czyli ilość danych

Gdy myślimy o ilości danych, powinniśmy zdawać sobie sprawę, że jest to pojęcie względne. Dla niektórych sektorów, albo firm dużą ilością będą tera i petabajty, podczas gdy dla innych może to być o rząd wielkości więcej (np. dla biznesów internetowych o dużej skali czy instytucji badawczych). Wiele zależy również od charakteru danych jakie przychodzi nam analizować. Informacje zawarte w ustrukturyzowanych bazach danych mogą być dużo większe w rozmiarze niż np. archiwa poczty elektronicznej, a mimo to ich przeszukiwanie i analiza będą dużo szybsze i mniej skomplikowane. W wielu przypadkach to jednak informacje zawarte w poczcie są dużo bardziej wartościowe dla firmy: mogą zawierać informacje o niezadowolonych klientach, kontrakty, oferty, projekty techniczne itp.). Jednocześnie przeszukiwanie i analiza takich danych potencjalnie nastręcza najwięcej problemów i wymaga relatywnie największej mocy obliczeniowej.

Variety czyli różnorodność danych

Różnorodność danych poddawanych analizie nie ogranicza się jedynie do podłączenia wielu systemów transakcyjnych. W Big Data chodzi o połączenie wielu typów danych – wspomnianych wcześniej ustrukturyzowanych i nieustrukturyzowanych, wewnętrznych i zewnętrznych, historycznych i aktualnych. Mieszanina taka może być bowiem bardzo interesująca z analitycznego punktu widzenia. Dobrym przykładem mogą być analizy ustrukturyzowanych danych z systemu ERP połączone z danymi geograficznymi i demograficznymi oraz danymi ze strony internetowej. Dzięki temu analityk jest w stanie nie tylko zidentyfikować źródła przychodu i wydajność poszczególnych oddziałów firmy w perspektywie historycznej, ale może zobaczyć dane w szerszym tle: potencjału gospodarczego regionu, statystyk sieciowych i popularności konkretnych produktów na stronie firmowej. Dodatkowo, jeśli system działa w czasie rzeczywistym, biznes może stosować określone promocje w celu poprawy wyników, tudzież promować określone towary na stronie internetowej firmy. Kolejnym przykładem takich połączeń jest choćby analiza danych pogodowych – a zatem danych ustrukturyzowanych ze stacji pogodowych i danych geograficzno-klimatycznych, pochodzących z obserwacji satelitarnych. Możliwość dołączenia tego typu analiz jest jednym z podstawowych kryteriów rozróżnienia między Big Data a klasyczną analityką.

Velocity – czyli szybkość analizy danych

Przetwarzanie danych w organizacjach odbywa się wciąż na różne sposoby – od przetwarzania wsadowego (batch processing) – gdzie dane ładowane są do systemu w określonych interwałach, do ciągłego przepływu danych z systemów transakcyjnych do systemów analitycznych. Chociaż pierwszy ze sposobów jest charakterystyczny dla klasycznych systemów opartych na hurtowniach danych, to w świecie Big Data również jest mocno obecny – właśnie tak dostarczane są dane do przetworzenia w środowisko Hadoop. Podobnie jest w przypadku np. danych pochodzących z inteligentnych liczników energii – porcje danych ładowane są do systemu zazwyczaj co kwadrans. Z kolei ciągły dopływ danych, to domena systemów typu CEP (Complex Event Processing), które są odpowiedzialne za reagowanie na określone zdarzenia, systemów do analizy tekstu i wyszukiwania i innych rozwiązań dedykowanych do automatycznej reakcji na zdarzenia i procesy w środowisku informatycznym (np. wykrywanie nadużyć w bankowości). Kluczami do oceny potrzeb w zakresie szybkości analizy Big Data są procesy biznesowe i wymagania użytkowników. Dobrym przykładem są np. fundusze hedgingowe inwestujące na rynkach światowych – w ich przypadku znaczenie mają ułamki sekund. Z drugiej strony wyszukiwarki sieciowe muszą często „przerobić” ogromne woluminy danych, jednak nie musi to się dokonywać w czasie rzeczywistym. Podsumowując – w Big Data liczy się właściwa informacja dostarczona we właściwym czasie i z właściwym poziomem dokładności.

Value czyli wartość

Wartość, to zdecydowanie najistotniejsza cecha wyróżniająca dla Big Data – zarówno w kontekście kosztu pozyskania technologii, jak i korzyści jakie organizacje mogą uzyskać w wyniku jej stosowania. Koszt technologii jest bardzo istotną różnicą w porównaniu z systemami z przeszłości, ponieważ poszczególne elementy układanki Big Data istniały od lat – tyle, że nie były powszechnie dostępne dla przeciętnej firmy. Wielkie hurtownie danych istniały w sektorze finansowym, telekomunikacyjnym, czy handlu detalicznym. Monitorowanie w czasie rzeczywistym również było obecne na rynku – chociażby w usługach finansowych (trading), przewidywaniu zjawisk pogodowych, czy wykrywaniu nadużyć. Analiza danych nieustrukturyzowanych w zakresie analizy tekstu również nie jest najnowszym wynalazkiem, podobnie jak superkomputery do zastosowań naukowych. To co wyróżnia obecną sytuację, to znacząco niższy koszt pozyskania wysokowydajnych technologii obliczeniowych i analitycznych. Jest to efekt spadających cen sprzętu komputerowego o wysokich parametrach oraz dostępności oprogramowania open source w „chmurze”.

Wartość odnosi się również do korzyści, jakie osiągają firmy i organy administracji w wyniku implementacji Big Data:

- Redukcja kosztów kapitałowych - oprogramowanie, sprzęt i inne

- Wydajność operacyjna – oszczędności w kosztach pracy wynikające z bardziej efektywnych metod integracji danych, zarządzania, analiz i dostarczania do użytkownika

- Udoskonalenie procesów biznesowych – zwiększenie obrotów i/lub zysku dzięki nowym lub lepszym sposobom prowadzenia biznesu w zakresie usprawnienia transakcji, zarządzania społecznościami klientów czy właściwej dystrybucji usług publicznych (zdrowotnych, edukacyjnych lub społecznych)

Nieporozumienia związane z Big Data

Podobnie jak w przypadku chmury, istnieje wiele nieporozumień dotyczących pojęcia Big Data. Wielu dostawców technologii i usług próbuje wykorzystać marketingowo to pojęcie przyczyniając się do stworzenia szeregu mitów na jego temat. Najpopularniejsze z nieporozumień to:

Podobnie jak w przypadku chmury, istnieje wiele nieporozumień dotyczących pojęcia Big Data. Wielu dostawców technologii i usług próbuje wykorzystać marketingowo to pojęcie przyczyniając się do stworzenia szeregu mitów na jego temat. Najpopularniejsze z nieporozumień to:

- Relacyjne bazy danych (RDBMS) mają ograniczenia skalowalności i dlatego nie są częścią koncepcji Big Data

- Hadoop (czy też inne środowiska oparte na koncepcji MapReduce), to najlepszy wybór w zakresie technologii Big Data niezależnie od obciążeń i zastosowania

- Epoka usystematyzowanych baz danych dobiegła końca, schematy tylko przeszkadzają we wdrożeniach Big Data - Wdrożenia Big Data potrzebne są tylko w celu przetwarzania analitycznego

- Analityka oparta na Big Data, to coś zupełnie nowego i innego, co nie było dostępne do czasu stworzenia obecnych technologii

Co dalej?

Big Data to wciąż młody i rozwijający się rynek. Podobnie jak na rynku Business Intelligence w jego początkach, napędzany jest on przez rzeszę małych, innowacyjnych firm, które próbują poszerzyć i przyspieszyć możliwości działania wielkich woluminów danych. Ich głównymi obszarami działalności są; organizacja i zarządzanie danymi, analizy i wyszukiwanie informacji. W Big Data zaangażowane są również wielkie międzynarodowe koncerny, które postrzegają Big Data jako kolejny czynnik wzrostu ich biznesu. Dodatkowo duże znaczenie dla rynku Big Data mają inicjatywy takie jak Hadoop czy NoSQL, które rzucają wyzwanie tradycyjnym podejściom, obecnym na rynku często już od ponad 30 lat. Ich właściwością jest także to, że umożliwiają społeczności przeprowadzanie operacji, które wydawało się, że nie będą nigdy możliwe bez wysoce wyspecjalizowanego oprogramowania i sprzętu.

12 Przed rynkiem Big Data stoi jednak wiele wyzwań. Aby w pełni się rozwinął, jego uczestnicy będą musieli trafnie odpowiedzieć na większość z nich. Do najważniejszych zaliczane są niedobory kadrowe – brak wystarczającej ilości osób z wysokimi umiejętnościami w zakresie zaawansowanych analiz.

Uniwersytety i inne placówki naukowe starają się odpowiedzieć na to wyzwanie, zwiększając ilość miejsc na kierunkach powiązanych z zaawansowana statystyką i naukami matematycznymi. Niedostatek umiejętności wśród załóg przedsiębiorstw będzie prowadził do prac nad rozwojem jednolitych platform dostępu do danych, które będą pozwalać nawet mniej obeznanym osobom na przeprowadzanie analiz na podstawie wielu źródeł – tak tradycyjnych jak i nieustrukturyzowanych. Intuicyjność jego obsługi będzie kluczem dla sukcesu rynkowego – tuż obok zaufania do jakości danych generowanych przez taki system. Firmy, które zainwestują w rozwój infrastruktury Big Data dostaną szansę nie tylko na poprawienie działania swoich dotychczasowych linii biznesowych, ale także stworzenia nowych, opartych na nowych informacjach o trendach konsumenckich lub oferowaniu dostępu do takich zbiorów innym podmiotom. Wiele firm, zwłaszcza w branżach o wielkich ilościach danych pochodzących od klientów (finanse, telekomunikacja, handel detaliczny, ochrona zdrowia, administracja państwowa) może w znaczący sposób podnieść wydajność swojej działalności i zmodyfikować procesy biznesowe, bazując na trendach uzyskanych z repozytoriów Big Data.

W kontekście samego rynku IT, w najbliższym czasie możemy spodziewać się kolejnej fali przejęć. W latach 2006-2007 producenci narzędzi BI Cognos, Business Objects i Hyperion zostali kupieni przez wielkich dostawców rozwiązań IT – odpowiednio: IBM, SAP i Oracle. Podobne zjawisko może nastąpić już wkrótce – obiektami przejęć będą firmy, które zademonstrują innowacyjne mechanizmy powiązane z Big Data, staną się liderami swoich rynków i wykażą się dobrą dynamiką przychodów. Klienci takich firm będą poszukiwali rozwiązań, które przybliżą ich do ideału analiz w czasie rzeczywistym. Zainteresowanie będzie ukierunkowane na oprogramowanie umożliwiające monitorowanie, powiadamianie, analizę i inteligentną automatykę procesów. Jednocześnie kontynuowana będzie presja na dostawców serwerów, pamięci masowych i urządzeń – klienci będą oczekiwali dalszego spadku cen przy jednoczesnej poprawie wydajności tak, aby być w stanie analizować coraz szybciej i coraz lepiej. Wielu użytkowników systemów Business Intelligence twierdzi, że powodują one w organizacji coraz większy „głód danych” – wśród użytkowników pojawia się coraz więcej potrzeb na coraz bardziej skomplikowane raporty i analizy. W przypadku Big Data zjawisko to zapewne ulegnie znacznemu nasileniu. Systemy Business Intelligence wciąż będą w firmach potrzebne – zaryzykuję stwierdzenie, że będzie ich coraz więcej, zarówno pod względem ilości firm jak i procentu pracowników mających do nich dostęp. Jednak prawdziwa transformacja biznesu będzie wynikała z właściwego wykorzystania możliwości, jakie daje nam Big Data.

W niniejszym artykule wykorzystany został raport IDC „IDC’s Worldwide Big Data Taxonomy, 2011”, October 2011, IDC#231099. W celu uzyskania dostępu do tego raportu i innych z zakresu Business Intelligence, Big Data i analityki biznesowej prosimy o kontakt z Pawłem Olechowskim, Account Managerem IDC Polska (

Źródło: http://robertjesionek.wordpress.com

Najnowsze wiadomości

Customer-specific AI: dlaczego w 2026 roku to ona przesądza o realnym wpływie AI na biznes

W 2026 roku sztuczna inteligencja przestaje być ciekawostką technologiczną, a zaczyna być rozliczana z realnego wpływu na biznes. Organizacje oczekują dziś decyzji, którym można zaufać, procesów działających przewidywalnie oraz doświadczeń klientów, które są spójne w skali. W tym kontekście coraz większe znaczenie zyskuje customer-specific AI - podejście, w którym inteligencja jest osadzona w danych, procesach i regułach konkretnej firmy, a nie oparta na generycznych, uśrednionych modelach.

PROMAG S.A. rozpoczyna wdrożenie systemu ERP IFS Cloud we współpracy z L-Systems

PROMAG S.A., lider w obszarze intralogistyki, rozpoczął wdrożenie systemu ERP IFS Cloud, który ma wesprzeć dalszy rozwój firmy oraz integrację kluczowych procesów biznesowych. Projekt realizowany jest we współpracy z firmą L-Systems i obejmuje m.in. obszary finansów, produkcji, logistyki, projektów oraz serwisu, odpowiadając na rosnącą skalę i złożoność realizowanych przedsięwzięć.

SkyAlyne stawia na IFS dla utrzymania floty RCAF

SkyAlyne, główny wykonawca programu Future Aircrew Training (FAcT), wybrał IFS Cloud for Aviation Maintenance jako cyfrową platformę do obsługi technicznej lotnictwa i zarządzania majątkiem. Wdrożenie ma zapewnić wgląd w czasie rzeczywistym w utrzymanie floty, zasoby i zgodność, ograniczyć przestoje oraz zwiększyć dostępność samolotów szkoleniowych RCAF w skali całego kraju. To ważny krok w modernizacji kanadyjskiego systemu szkolenia załóg lotniczych.

Wykorzystanie AI w firmach rośnie, ale wolniej, niż oczekiwano. Towarzyszy temu sporo rozczarowań

Wykorzystanie sztucznej inteligencji w firmach rośnie, ale tempo realnych wdrożeń pozostaje znacznie wolniejsze od wcześniejszych oczekiwań rynku. Dane pokazują, że z rozwiązań AI korzysta dziś wciąż niewiele przedsiębiorstw, a menedżerowie coraz częściej wskazują na bariery regulacyjne, koszty oraz brak powtarzalnych efektów biznesowych. W praktyce technologia jest testowana głównie w wybranych obszarach, a kluczowe decyzje nadal pozostają po stronie człowieka. Również w firmach, które wdrożyły AI, nierzadko towarzyszą temu rozczarowania.

Europejski przemysł cyfryzuje się zbyt wolno – ERP, chmura i AI stają się koniecznością

Europejski przemysł średniej wielkości wie, że cyfryzacja jest koniecznością, ale wciąż nie nadąża za tempem zmian. Ponad 60% firm ocenia swoje postępy w transformacji cyfrowej jako zbyt wolne, mimo rosnącej presji konkurencyjnej, regulacyjnej i kosztowej. Raport Forterro pokazuje wyraźną lukę między świadomością potrzeby inwestycji w chmurę, ERP i AI a realną zdolnością do ich wdrożenia – ograniczaną przez braki kompetencyjne, budżety i gotowość organizacyjną.

Europejski przemysł średniej wielkości wie, że cyfryzacja jest koniecznością, ale wciąż nie nadąża za tempem zmian. Ponad 60% firm ocenia swoje postępy w transformacji cyfrowej jako zbyt wolne, mimo rosnącej presji konkurencyjnej, regulacyjnej i kosztowej. Raport Forterro pokazuje wyraźną lukę między świadomością potrzeby inwestycji w chmurę, ERP i AI a realną zdolnością do ich wdrożenia – ograniczaną przez braki kompetencyjne, budżety i gotowość organizacyjną.

Najnowsze artykuły

5 pułapek zarządzania zmianą, które mogą wykoleić transformację cyfrową i wdrożenie ERP

Dlaczego jedne wdrożenia ERP dowożą korzyści, a inne kończą się frustracją, obejściami w Excelu i spadkiem zaufania do systemu? Najczęściej decyduje nie technologia, lecz to, jak organizacja prowadzi zmianę: czy liderzy biorą odpowiedzialność za decyzje czy tempo jest dopasowane do zdolności absorpcji oraz czy ludzie dostają klarowność ról i realne kompetencje. Do tego dochodzi pytanie: co po go-live - stabilizacja czy chaos w firmie? Poniżej znajdziesz 5 pułapek, które najczęściej wykolejają transformację i praktyczne sposoby, jak im zapobiec.

SAP vs Oracle vs Microsoft: jak naprawdę wygląda chmura i sztuczna inteligencja w ERP

Wybór systemu ERP w erze chmury i sztucznej inteligencji to decyzja, która determinuje sposób działania organizacji na lata — a często także jej zdolność do skalowania, adaptacji i realnej transformacji cyfrowej. SAP, Oracle i Microsoft oferują dziś rozwiązania, które na pierwszy rzut oka wyglądają podobnie, lecz w praktyce reprezentują zupełnie odmienne podejścia do chmury, AI i zarządzania zmianą. Ten artykuł pokazuje, gdzie kończą się deklaracje, a zaczynają realne konsekwencje biznesowe wyboru ERP.

Transformacja cyfrowa z perspektywy CFO: 5 rzeczy, które przesądzają o sukcesie (albo o kosztownej porażce)

Transformacja cyfrowa w finansach często zaczyna się od pytania o ERP, ale w praktyce rzadko sprowadza się wyłącznie do wyboru systemu. Dla CFO kluczowe jest nie tylko „czy robimy pełną wymianę ERP”, lecz także jak policzyć ryzyko operacyjne po uruchomieniu, ocenić wpływ modelu chmurowego na koszty OPEX oraz utrzymać audytowalność i kontrolę wewnętrzną w nowym modelu działania firmy.

Agentic AI rewolucjonizuje HR i doświadczenia pracowników

Agentic AI zmienia HR: zamiast odpowiadać na pytania, samodzielnie realizuje zadania, koordynuje procesy i podejmuje decyzje zgodnie z polityką firmy. To przełom porównywalny z transformacją CRM – teraz dotyczy doświadczenia pracownika. Zyskują HR managerowie, CIO i CEO: mniej operacji, więcej strategii. W artykule wyjaśniamy, jak ta technologia redefiniuje rolę HR i daje organizacjom przewagę, której nie da się łatwo nadrobić.

Composable ERP: Przewodnik po nowoczesnej architekturze biznesowej

Czy Twój system ERP nadąża za tempem zmian rynkowych, czy stał się cyfrową kotwicą hamującą rozwój? W dobie nieciągłości biznesowej tradycyjne monolity ustępują miejsca elastycznej architekturze Composable ERP. To rewolucyjne podejście pozwala budować środowisko IT z niezależnych modułów (PBC) niczym z klocków, zapewniając zwinność nieosiągalną dla systemów z przeszłości. W tym raporcie odkryjesz, jak uniknąć pułapki długu technologicznego, poznasz strategie liderów rynku (od SAP po MACH Alliance) i wyciągniesz lekcje z kosztownych błędów gigantów takich jak Ulta Beauty. To Twój strategiczny przewodnik po transformacji z cyfrowego "betonu" w adaptacyjną "plastelinę".

Oferty Pracy

-

Młodszy konsultant programista Microsoft Dynamics 365 Business Central

-

Konsultant programista Microsoft Dynamics 365 Business Central

-

Konsultant Microsoft Dynamics 365

-

Konsultant Wdrożeniowy Symfonia – księgowość

-

Microsoft Fabric Engineer (MFE)

-

Data/Business Analyst (PBI/Fabric)

-

CRM consultant

-

Starszy architekt systemów rozproszonych

-

Inżynier Zastosowań AI

Przeczytaj Również

Real-Time Intelligence – od trendu do biznesowego must-have

Sposób prowadzenia działalności gospodarczej dynamicznie się zmienia. Firmy muszą stale dostosowywa… / Czytaj więcej

EPM – co to jest? Czy jest alternatywą dla BI?

Nowoczesne systemy BI i EPM dostarczają wiedzy potrzebnej do efektywnego zarządzania firmą. Czy zna… / Czytaj więcej

W jaki sposób firmy zwiększają swoją odporność na zmiany?

Do zwiększenia odporności na zmiany, konieczna jest pełna kontrola nad codziennymi procesami zapewn… / Czytaj więcej

Dlaczego systemy kontrolingowe są potrzebne współczesnym firmom?

Narzędzia Corporate Performance Management (CPM) pozwalają na przyśpieszenie tempa podejmowania dec… / Czytaj więcej

Hurtownie danych – funkcje i znaczenie dla BI

Przepisów na sukces biznesu jest na rynku wiele. Nie ulega jednak wątpliwości, że jednym z kluczowy… / Czytaj więcej

Po co dane w handlu? Okazuje się, że ich analityka może dać nawet 30 proc. większe zyski!

Jak wynika z badania firmy doradczej Capgemni, producenci FMCG oraz firmy związane z handlem detali… / Czytaj więcej